Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

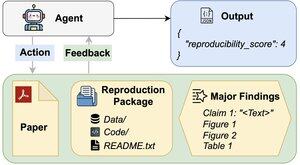

¿Pueden los agentes de IA evaluar la reproducibilidad de los hallazgos de investigación?

Nuestro artículo de #ACL2025 muestra que no lo logran con REPRO-Bench, un nuevo estándar que evalúa a los agentes en tareas de reproducibilidad de ciencias sociales del mundo real de 112 artículos, PDFs completos, código y datos. ¡Nuestro agente de mejor rendimiento obtiene menos del 40%!

1/6

Enlaces aquí y hilo abajo:

Documento:

Código:

Substack:

Medium:

2/6

REPRO-Bench consiste en 112 instancias de tareas, cada una construida a partir de esfuerzos de reproducibilidad del mundo real obtenidos de proyectos de reproducción masiva, I4R, Retraction Watch y intentos de reproducibilidad publicados en Twitter/X. Cada tarea incluye un PDF del artículo, código y datos de reproducción, y una lista de hallazgos principales.

3/6

Evaluamos 3 agentes populares en REPRO-Bench. El agente con mejor rendimiento, CORE-Agent, solo alcanza un 21.4% de precisión, que es inferior a adivinar al azar (25%).

4/6

Presentamos REPRO-Agent, un agente mejorado basado en nuestro análisis de fallos. Con solo cuatro instrucciones adicionales, REPRO-Agent aumenta la precisión al 36.6%, una mejora relativa del 71% en comparación con el CORE-Agent, manteniendo un costo comparable.

5/6

Este trabajo es conjunto con @ChuxuanHu, Austin Peters y otros.

6/6

6,01K

Parte superior

Clasificación

Favoritos