Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

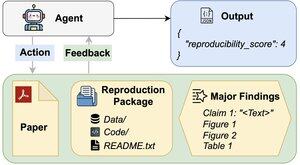

Czy agenci AI mogą ocenić powtarzalność wyników badań?

Nasz artykuł na #ACL2025 pokazuje, że nie spełniają oczekiwań w przypadku REPRO-Bench, nowego benchmarku, który ocenia agentów w rzeczywistych zadaniach z zakresu powtarzalności nauk społecznych na podstawie 112 prac, pełnych PDF-ów, kodu i danych. Nasz najlepiej działający agent uzyskuje wynik <40%!

1/6

Linki tutaj i wątek poniżej:

Dokument:

Kod:

Substack:

Medium:

2/6

REPRO-Bench składa się z 112 instancji zadań, z których każda oparta jest na rzeczywistych wysiłkach w zakresie reprodukcji, pochodzących z projektów masowej reprodukcji, I4R, Retraction Watch oraz prób reprodukcji publikowanych na Twitterze/X. Każde zadanie zawiera PDF artykułu, kod i dane reprodukcyjne oraz listę głównych ustaleń.

3/6

Oceniamy 3 popularnych agentów na REPRO-Bench. Najlepiej działający agent, CORE-Agent, osiąga tylko 21,4% dokładności, co jest niższe niż losowe zgadywanie (25%).

4/6

Wprowadzamy REPRO-Agent, ulepszony agent oparty na naszej analizie awarii. Dzięki zaledwie czterem dodatkowym instrukcjom, REPRO-Agent zwiększa dokładność do 36,6%, co stanowi 71% względnej poprawy w porównaniu do CORE-Agenta, przy jednoczesnym utrzymaniu porównywalnych kosztów.

5/6

Ta praca jest wspólna z @ChuxuanHu, Austinem Petersem i innymi.

6/6

6,66K

Najlepsze

Ranking

Ulubione