Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

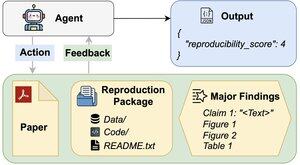

Kan AI-agenter bedöma reproducerbarheten av forskningsresultat?

Vår #ACL2025-rapport visar att de inte når upp till REPRO-Bench, ett nytt riktmärke som utvärderar agenter på verkliga samhällsvetenskapliga reproducerbarhetsuppgifter för 112 artiklar, fullständiga PDF-filer, kod och data. Vår bäst presterande agent får <40 %!

1/6

Länkar här och tråd nedan:

Papper:

Kod:

Understack:

Medium:

2/6

REPRO-Bench består av 112 uppgiftsinstanser, var och en byggd av verkliga reproducerbarhetsinsatser som kommer från massreproduktionsprojekt, I4R, Retraction Watch och reproducerbarhetsförsök som publicerats på Twitter/X. Varje uppgift innehåller en PDF-fil i pappersformat, reproduktionskod och data samt en lista över viktiga upptäckter.

3/6

Vi utvärderar 3 populära agenter på REPRO-Bench. Den bäst presterande agenten, CORE-Agent, uppnår endast 21,4 % noggrannhet, vilket är lägre än slumpmässig gissning (25 %).

4/6

Vi introducerar REPRO-Agent, ett förbättrat medel baserat på vår felanalys. Med bara fyra ytterligare instruktioner ökar REPRO-Agent noggrannheten till 36,6 %, en relativ förbättring med 71 % jämfört med CORE-Agent, samtidigt som den jämförbara kostnaden bibehålls.

5/6

Detta arbete är gemensamt med @ChuxuanHu, Austin Peters och andra.

6/6

6,01K

Topp

Rankning

Favoriter