Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

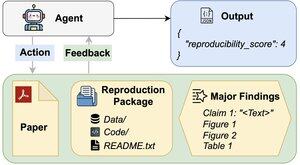

Kan AI-agenter vurdere reproduserbarheten til forskningsresultater?

Vår #ACL2025 artikkel viser at de kommer til kort med REPRO-Bench, en ny målestokk som evaluerer agenter på virkelige samfunnsvitenskapelige reproduserbarhetsoppgaver på 112 artikler, fullstendige PDF-er, kode og data. Vår best presterende agent scorer <40%!

1/6

Lenker her og tråd nedenfor:

Papir:

Kode:

Substack:

Middels:

2/6

REPRO-Bench består av 112 oppgaveforekomster, hver bygget fra reproduserbarhetsinnsats fra den virkelige verden hentet fra massereproduksjonsprosjekter, I4R, Retraction Watch og reproduserbarhetsforsøk lagt ut på Twitter/X. Hver oppgave inkluderer en papir-PDF, reproduksjonskode og data, og en liste over viktige funn.

3/6

Vi vurderer 3 populære agenter på REPRO-Bench. Den beste agenten, CORE-Agent, oppnår bare 21,4 % nøyaktighet, noe som er lavere enn tilfeldig gjetting (25 %).

4/6

Vi introduserer REPRO-Agent, et forbedret middel basert på vår feilanalyse. Med bare fire ekstra instruksjoner øker REPRO-Agent nøyaktigheten til 36,6 %, en relativ forbedring på 71 % i forhold til CORE-Agent, samtidig som sammenlignbare kostnader opprettholdes.

5/6

Dette arbeidet er felles med @ChuxuanHu, Austin Peters og andre.

6/6

6,65K

Topp

Rangering

Favoritter