Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

宝玉

Prompt Engineer, dedikert til å lære og spre kunnskap om AI, programvareteknikk og ingeniørledelse.

I dag er det en nyhet som er veldig populær på Hacker News, nyhetsinnholdet er at Californias arbeidsledighet har klatret til 5,5 %, bunnen av USA, og teknologiindustrien sliter: "Arbeidsmarkedet er for grusomt".

> Californias arbeidsledighet steg til 5,5 % i juli, den høyeste blant noen stat i USA, ifølge statlige regjeringsdata utgitt fredag. Bak dette ligger fortsatt svakhet i jobber i teknologibransjen og andre kontorjobber, samt en nedgang i rekrutteringsmarkedet.

Nyhetene tilskrev dette svakheten i teknologisektoren, som er en sentral del av Californias økonomi. Nyheten ble heftig diskutert i Hacker News-fellesskapet, og de underliggende årsakene bak den ble analysert fra deres egne perspektiver, langt mer komplekse enn overskriften antydet.

Jeg tror denne diskusjonen er en god oppsummering av hvorfor sysselsettingen i teknologibransjen for tiden er treg.

1. Først og fremst er kjernepoenget: si farvel til de mange følgene av "nullrente-æraen"

Dette er det mest mainstream og dyptgripende punktet i diskusjonen. Mange mener at den nåværende teknologiindustriens problemer ikke er forårsaket av en enkelt faktor, men snarere en ringvirkning av slutten på Zero Interest Rate Policy (ZIRP)-æraen det siste tiåret.

- Kapitalboblen sprakk: Fra rundt 2012 til 2022 gjorde ekstremt lave renter kapital uvanlig billig. Tilstrømningen av venturekapital (VC) til teknologibransjen har skapt utallige forretningsmodeller som er avhengige av "brennende" vekst, spesielt krypto- og metaverse-selskaper som mangler reell verdi. Da Fed hevet renten, tok æraen med billige penger slutt, og pengekjedene til disse selskapene brøt, noe som førte til en rekke permitteringer og nedleggelser.

- Ubalanse i talenttilbud og etterspørsel: I ZIRP-æraen har myten om høye lønninger i teknologibransjen tiltrukket seg en tilstrømning av talenter. Den massive utvidelsen av informatikkprogrammer (CS) ved universiteter, blomstringen av oppstartsleirer og teknisk innvandring har ført til en dramatisk økning i tilbudet av programvareingeniører det siste tiåret. Men etter hvert som kapitalen ebbet ut, krympet etterspørselssiden, spesielt startups, kraftig, og skapte et alvorlig overskudd av talent.

- Ringvirkninger i bransjer som bioteknologi: Bransjer som bioteknologi, som også er avhengige av langsiktige høyrisikoinvesteringer, har også blitt hardt rammet. Disse bransjene er enda mer avhengige av billig kapital enn programvareindustrien. Etter slutten av ZIRP tørket VC-midlene gradvis ut, og startups kunne ikke få en ny finansieringsrunde etter å ha gått tom for "runway funds" (runway), og måtte si opp ansatte eller gå konkurs.

> (av tqi): «Etter min mening er det for tidlig å si at 'AI' har en betydelig innvirkning på ansettelser av programvareselskaper. En mer plausibel forklaring er at mellom 2012 og 2022 økte talenttilgangen for programvareingeniører betydelig... På etterspørselssiden er VC-fond i nullrente-æraen hovedsakelig investert i tullete kryptovaluta- og metaverse-selskaper, hvorav de fleste ikke har lyktes, noe som resulterer i mangel på sene eller nye børsnoterte selskaper i markedet som kan absorbere disse talentene. ”

2. Det "tveeggede sverdet" for fjernarbeid: en ny bølge av global outsourcing

COVID-19-pandemien har popularisert Work From Home (WFH), som ble sett på som en velsignelse av mange utviklere på den tiden, men nå begynner de negative effektene å dukke opp.

- Baner vei for outsourcing:Når utviklere kjemper for retten til å jobbe helt eksternt, er de kanskje ikke klar over det, noe som også åpner døren for selskaper til å outsource jobber til lavkostland. Siden alle er eksternt, hvorfor ikke ansette en indisk eller østeuropeisk ingeniør som bare er 1/5 av en amerikansk ingeniør og er like god?

- «Ingen tilbake til kontoret»-kontorer: Noen kommentatorer mener at «Return to Office (RTO»-politikken som fremmes av teknologiselskaper delvis er rettet mot å beskytte lokale arbeidsplasser). Når jobben viser seg å være 100 % ekstern, kan den gjøres hvor som helst i verden, og lønnsfordelen for amerikanske ingeniører vil ikke lenger eksistere.

- Outsourcing Quality Debate: Noen hevder at outsourcing har pågått i flere tiår, og programvareutvikling av høy kvalitet krever fortsatt topp lokale talenter på grunn av problemer som kommunikasjonskostnader, tidssoneforskjeller og kulturell bakgrunn. De som støtter outsourcing-perspektivet mener imidlertid at disse hindringene blir overvunnet etter hvert som eksterne samarbeidsverktøy modnes og ledelsesmodellene forbedres.

> (av aurareturn): «Jeg har sagt på HN siden 2022: alle nordamerikanske utviklere som støtter fullstendig eksternt arbeid, vil du bli overrasket når bedriften din bestemmer seg for å erstatte deg med noen fra utlandet. Siden alt er eksternt, hvorfor skal selskapet ansette deg for 5 ganger prisen i stedet for en utenlandsk ansatt som jobber hardere og klager mindre? ... Å støtte ordren om å komme tilbake til kontoret kan redde karrieren din i det lange løp. ”

3. Rollen til AI: Er det et produktivitetsverktøy, en unnskyldning for å si opp ansatte eller en stor "vampyr"?

Når det gjelder rollen til kunstig intelligens (AI) i denne bølgen av tap av arbeidsplasser, presenterer diskusjonen et komplekst skille.

- Begrenset direkte erstatningseffekt: De fleste er enige om at dagens AI ikke fullt ut kan erstatte erfarne programvareingeniører. Men det har begynt å erstatte noen junior- og repeterende oppgaver, for eksempel noen små konsulentoppgaver. En konsulent kom frem og sa at kunden sluttet å kontakte ham fordi ChatGPT kunne løse noen mindre feil.

- Den "perfekte unnskyldningen" for permitteringer: En vanlig oppfatning er at AI har blitt den "perfekte unnskyldningen" for bedrifter til å si opp ansatte og redusere kostnader og øke effektiviteten. Selv om årsaken til permitteringer er en økonomisk nedgang eller ledelsesbeslutninger, pakker bedrifter det gjerne inn som en strategisk justering for å "omfavne AI og forbedre effektiviteten".

- Kapitalens «svarte hull»: AI spiller en annen nøkkelrolle – den suger bort den eneste gjenværende risikokapitalen i markedet som kunne ha strømmet til andre teknologisektorer. VC-er er nå nesten utelukkende interessert i AI-prosjekter, noe som har forverret finansieringsvanskene til startups innen ikke-AI-feltet.

4. "Rustsonen" i teknologiindustrien? Strukturelle bekymringer for fremtiden

Noen paneldeltakere uttrykte bekymring for fremtiden fra et bredere perspektiv, og trakk paralleller mellom teknologiindustrien og den en gang strålende og deretter synkende produksjonen «Rust Belt».

- Gjentatte tap av arbeidsplasser: Akkurat som USA outsourcet produksjon til Kina, strømmer IT- og programvareutviklingsjobber nå til India, Latin-Amerika og Øst-Europa i stor skala. Dette kan føre til langsiktig strukturell arbeidsledighet for den en gang godt betalte programvareingeniørgruppen.

- Politisk og sosial innvirkning: Hvis et betydelig antall middelklassejobber i teknologibransjen forsvinner, kan det utløse nye sosiale og politiske problemer, omtrent som nedgangen i rustbeltet som fortsatt påvirker det amerikanske politiske landskapet i dag.

- Immigrasjons- og visumpolitisk kontrovers (H1B/O1): En del av diskusjonen pekte fingeren mot arbeidsvisum som H1B, og argumenterte for at de ble misbrukt, presset ned lokale ingeniørlønninger og økte konkurransen. Andre er trofaste forsvarere av dyktig migrasjon, og hevder at det er disse topptalentene fra hele verden, for eksempel nyutdannede fra University of Waterloo, som utgjør hjørnesteinen i innovasjon i Silicon Valley.

5. Bedriftsledelse og kulturendring: "Musk-effekten"

Et interessant synspunkt er at Musk har hatt en eksemplarisk effekt på Twitters (nå X) massive permitteringer.

- Rasjonalisering av permitteringer: Da Musk sa opp mer enn 75 % av Twitters ansatte, var produktet fortsatt funksjonelt, noe som fikk mange administrerende direktører til å reflektere: «Siden han kan gjøre det, hvorfor kan ikke jeg?» Dette bryter med "mer talent, jo bedre"-tankegangen til teknologiselskaper tidligere, og gjør storskala permitteringer mer akseptable både psykologisk og kommersielt.

6. Politiske og politiske faktorer: Kontrovers om endringer i skattelovgivningen

En teknisk, men vidtrekkende ledetråd handler om endringer i amerikanske skattelover.

- Regel for amortisering av FoU-utgifter (seksjon 174): Det er en bestemmelse i Trump-administrasjonens Tax Reform Act (TCJA) i 2017 som krever at selskaper amortiserer forsknings- og utviklingsutgifter (FoU) som programvareutviklingslønn i avdrag over fem år fra og med 2022, i stedet for å bli trukket helt fra i inneværende år som før. Dette har økt skattebyrden på teknologiselskaper, spesielt startups, og motvirket ansettelsesintensjoner i USA.

- Gjenopprettende effekt av nylige lovforslag: Det nylig vedtatte Build Back Better (BBB)-lovforslaget korrigerer delvis dette problemet, slik at innenlandske FoU-utgifter umiddelbart kan trekkes fra igjen. Noen kommentatorer mener at de følte en oppgang i ansettelsesmarkedet rundt juli, noe som kan ha noe med det å gjøre.

Til slutt

Ut fra disse diskusjonene å dømme er årsakene til den nåværende sysselsettingsnedgangen i Californias teknologiindustri ganske komplekse, ikke forårsaket av en enkelt faktor, og det kan heller ikke bare tilskrives "AI erstatter mennesker" eller "syklisk resesjon i bransjen", men resultatet av den økonomiske resesjonen etter slutten av nullrente-æraen, restruktureringen av det globale arbeidsmarkedet forårsaket av fjernarbeid, den doble effekten av AI som en ny teknologi og en kapitalmagnet, og endringer i spesifikk skattepolitikk.

Jeg vet ikke når jeg kommer meg ut av denne knipa? Eller årsaken er ikke bare disse diskutert ovenfor

46,42K

Oversettelse: Hvorfor store språkmodeller egentlig ikke kan bygge programvare

Av Conrad Irwin

En ting jeg bruker mye tid på er å intervjue programvareingeniører. Dette er åpenbart en vanskelig oppgave, og jeg tør ikke si at jeg har noen triks; Men det ga meg tid til å reflektere over hva en effektiv programvareingeniør gjør.

Kjernesyklusen for programvareutvikling

Når du ser på en ekte kjenner, vil du se at de alltid utfører følgende trinn i en syklus:

* Bygg en mental modell av behov.

* Skriv (forhåpentligvis?!) ) som implementerer kravene.

* Bygg en mental modell av hvordan koden din faktisk oppfører seg.

* Finn forskjellen mellom de to, og oppdater deretter koden (eller kravet).

Det er mange måter å oppnå disse trinnene på, men det fine med effektive ingeniører er deres evne til å bygge og vedlikeholde klare mentale modeller.

Hvordan fungerer store språkmodeller?

For å være rettferdig er store språkmodeller ganske flinke til å skrive kode. De gjør også en god jobb med å oppdatere koden når du påpeker problemet. De kan også gjøre alle tingene en ekte ingeniør ville gjort: lese kode, skrive og kjøre tester, legge til logger og (antagelig) bruke feilsøkingsprogrammet.

Men det de ikke kan gjøre er å opprettholde en klar mental modell.

Store språkmodeller vil falle i endeløs forvirring: de vil anta at koden de skriver faktisk er brukbar; Når en test mislykkes, kan de bare gjette om det er en fikskode eller en test fikset; Når de blir frustrerte, kutter de rett og slett alt ut og begynner på nytt.

Dette er det stikk motsatte av hva jeg ville forvente av en ingeniør.

Programvareingeniører tester mens de jobber. Når en test mislykkes, kan de bruke sin mentale modell til å avgjøre om de skal fikse koden eller testen, eller samle mer informasjon før de tar en avgjørelse. Når de føler seg frustrerte, kan de be om hjelp ved å kommunisere med folk. Selv om de noen ganger sletter alt og starter på nytt, er det et valg som tas etter en klarere forståelse av problemet.

Men det blir snart, ikke sant?

Vil dette endre seg etter hvert som modellene blir mer kapable? Kanskje?? Men jeg tror dette krever en grunnleggende endring i måten modeller bygges og optimaliseres på. Programvareutvikling krever modeller som er mer enn bare å generere kode.

Når en person støter på et problem, er de i stand til midlertidig å legge til side hele konteksten og fokusere på å løse problemet, og deretter gå tilbake til det store problemet. De kan også bytte mellom det store bildet og mikrodetaljene, midlertidig ignorere detaljene for å fokusere på helheten, og grave i delene når det er nødvendig. Vi blir ikke mer produktive bare ved å stappe flere ord inn i vårt "kontekstvindu", det vil bare gjøre oss gale.

Selv om vi kan håndtere en stor mengde kontekst, vet vi at disse generative modellene for tiden har flere alvorlige problemer som direkte påvirker deres evne til å opprettholde klare mentale modeller:

* Kontekstuell utelatelse: Modeller er ikke flinke til å oppdage oversett kontekstuell informasjon.

* Recency-skjevhet: De er utsatt for alvorlig nylighetsskjevhet når du arbeider med kontekstvinduer.

* Hallusinasjoner: De "fantaserer" ofte om detaljer som ikke burde eksistere.

Disse problemene er kanskje ikke uoverkommelige, og forskere jobber med å legge til minne i modeller slik at de kan utøve lignende tenkeferdigheter som vi gjør. Men dessverre, foreløpig, kan de (etter å ha gått utover et visst nivå av kompleksitet) egentlig ikke forstå hva som egentlig skjedde.

De kan ikke bygge programvare fordi de ikke kan opprettholde to like "mentale modeller" samtidig, finne ut forskjellene og bestemme om de skal oppdatere kode eller oppdatere krav.

Så, hva nå?

Det er klart at store språkmodeller er nyttige for programvareingeniører. De genererer kode raskt og utmerker seg ved å integrere krav og dokumentasjon. For noen oppgaver er dette nok: kravene er klare nok, problemene er enkle nok til at de kan gjøres over natten.

Når det er sagt, for enhver oppgave av en viss kompleksitet, kan de ikke opprettholde nok kontekst nøyaktig nok til å iterere til å endelig produsere en levedyktig løsning. Som programvareingeniør er du fortsatt ansvarlig for å sikre at kravene er tydelige og at koden faktisk leverer det den hevder å gjøre.

Hos Zed tror vi på en fremtid der mennesker og AI-agenter kan bygge programvare sammen. Vi er imidlertid overbevist om (i hvert fall foreløpig) at du er sjåføren bak rattet, og at store språkmodeller bare er enda et verktøy for hånden.

62,82K

宝玉 lagt ut på nytt

I går dro jeg til CSDNs produktsjefskonferanse for å holde en presentasjon.

Da vennene mine i CSDN inviterte meg til å holde en tale på Product Manager Conference for tre måneder siden, ville jeg faktisk takke nei.

Årsaken er at oppstarten min bare har vært etablert i et halvt år, og jeg har ikke mye innsikt å dele med deg.

CSDN-venner sa imidlertid at det ikke spiller noen rolle, konferansen er fortsatt tre måneder unna, og det er fortsatt tid, og vi kan også dele litt tidligere produkterfaring.

Tilfeldigvis, etter at vi ga ut FlowSpeech forrige uke, eksploderte produktets omdømme, MRR økte med 3 ganger, ARR brøt også et lite mål, og enda viktigere, brukerne våre tjente ekte penger ved å bruke produktet, som er det beste beviset på styrken til produktet vårt.

Så da jeg holdt en tale i går, spøkte jeg med deg om at gullinnholdet i denne PPT i dag har skutt i været, vær så snill å lytte nøye.

37,38K

«Som bonde kjøper jeg bare økologisk mat; Som AI-utøver ser jeg bare på ikke-AI-generert innhold.» 😅

马东锡 NLP 🇸🇪15. aug., 16:12

Jeg vet ikke med deg, men som AI-utøver avviser jeg instinktivt å gå inn i noe AI-generert.

Når jeg gjennomgår koden, når jeg føler at den er skrevet av AI, skriver jeg LGTM direkte.

Når du leser en artikkel, så lenge du legger merke til at den er AI-generert, slå den av umiddelbart.

Hvis nettstedets brukergrensesnitt ser AI-generert ut, slå det av umiddelbart.

Hvis podcasten er AI-generert, slå den av umiddelbart.

Hvis den korte videoen er AI-generert, kryss den ut umiddelbart og erstatt den med en bruktbilforhandler eller en video av reparasjon av et eselhover.

Jeg føler at det er uansvarlig for kroppen og ånden min å la AI-generert innhold lure dopaminendorfinene mine.

AI-generert innhold er absolutt verdifullt, men det er begrenset til mellomproduktet av endelig menneskelig input og output, og bør ikke og kan ikke sirkulere som en endelig form på lenge.

62,01K

Vibe Coding er et dårlig begrep og misvisende, og den største betydningen er at den bruker AI for prototyping, noe som kan bidra til raskt å bestemme produktkrav. I programvareutvikling blir koden for prototypeutvikling vanligvis forlatt, og systemet må redesignes, kodes og implementeres når produktet offisielt utvikles.

铁锤人14. aug., 21:07

Det er anslått at mange ikke vet hva Vibe Coding er?

Begrepet ble laget av kunstig intelligens-guden Andre Karpathy,

Når du beskriver problemet til AI, skriver den sin egen kode.

Kun for enkle helgeprosjekter som bare du vil bruke

Fordi det er et uviktig prosjekt, kan han handle på følelsene sine uten å måtte planlegge eller teste.

👇 Det er her drømmer begynner

48,07K

I kontekstteknikk må agenten bruke verktøy og miljøer for å hente data og fullføre konteksten

dontbesilent14. aug., 05:13

Jeg forsto plutselig hva claude-kode og komet handler om, og hvorfor agenter dukker opp i CLI og nettleseren, og har blitt mainstream-valg

Hvor agenten dukker opp betyr noe!

Utviklere liker å bruke claude-kode fordi koden deres kan kontrolleres gjennom CLI, og koden er faktisk konteksten for kommunikasjon med den store modellen

Men jeg kastet rundt i dag og fant ut at folk som driver med selvmedier ikke kan bruke det, fordi folk som driver med selvmedier ikke har noe på datamaskinene sine i det hele tatt, og kjerneinnholdet er i apper og nettlesere

Claude-kode er imidlertid vanskelig å få ting i nettlesere og apper, så kjerneproblemet er ikke om jeg bruker sonett eller opus, men at denne agenten ikke skal vises på kommandolinjen

Denne agenten skal vises i nettleseren! For eksempel har Douyin blåst coze-arbeidsflyten som fanger opp Xiaohongshu-data, og det gjøres direkte med COMET

For de som driver med selvmediering, er komet den virkelige claude-koden, fordi agenten til selvmediepersonen må vises i nettleseren

Den forrige dia-nettleseren var dum sammenlignet med den forrige dia-nettleseren, som ikke var en agent, men en LLM

Hvis du bare kobler en LLM til nettleseren, tror jeg det gir liten mening

15,09K

Selvstudium i informatikk TeachYourselfCS

Hvis du er en selvlært ingeniør eller uteksaminert fra et programmeringskurs, er det nødvendig for deg å studere informatikk. Heldigvis trenger du ikke bruke år og mye penger på en grad: du kan få en utdanning 💸 i verdensklasse på egen hånd.

På Internett er det mange læringsressurser overalt, men essensen og slagget eksisterer side om side. I stedet for en liste som "200+ gratis nettkurs", trenger du svar på spørsmål som:

Hvilke bør du studere og hvorfor?

Hva er det beste bok- eller videokurset for disse fagene?

I denne veiledningen prøver vi å gi definitive svar på disse spørsmålene.

Deedy14. aug., 09:59

"Lær deg selv informatikk" er den beste ressursen for å lære data.

2 uker inn i vibe-koding og ikke-tekniske mennesker føler smerten. «Jeg skulle virkelig ønske jeg var teknisk. Jeg vet bare ikke hvordan jeg skal gå frem.»

Det tar ~1000 timer på tvers av 9 emner å forstå CS med hvilken som helst dybde.

152,07K

宝玉 lagt ut på nytt

Her kommer vennene mine~ Jeg tjener bare 20 yuan for 3 millioner brukere: den falske boomen av AI-verktøy - ListenHub

Hvem ville ikke fortelle en vits. Mange mennesker var interessert i saken jeg delte på Hard Ground Hacking, og jeg laget en podcast spesielt på @oran_ge's ListenHub. Du kan lytte til den~

29,23K

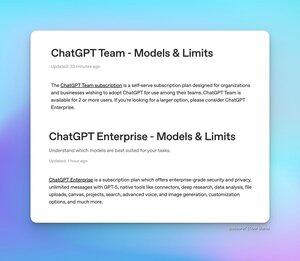

Mange venner er bekymret for bruksbegrensningene til ChatGPT Team og Enterprise, og nå har to nye ofte stilte spørsmål (FAQ)-artikler blitt utgitt for å forklare dette.

* ChatGPT Team Edition - GPT-5 og GPT-4o er ubegrenset, men det er følgende begrensninger for forskjellige modellversjoner:

* 200 GPT-5 Thinking-forespørsler per dag

* 2800 GPT-5 Thinking miniforespørsler per uke

* 15 GPT-5 Pro-forespørsler per måned

* 3 GPT-500-forespørsler hver 4.1 time

* 300 O4-mini- og O3-forespørsler per dag

* ChatGPT Enterprise - GPT-5, GPT-4o og GPT-4.1-mini er ubegrensede, men det er følgende begrensninger for forskjellige modellversjoner:

* 200 GPT-5 Thinking-forespørsler per uke

* 15 GPT-5 Pro-forespørsler per måned

* 20 GPT-4.5-forespørsler per uke

* 3 GPT-500-forespørsler hver 4.1 time

* 300 O4-mini-forespørsler per dag

* 100 forespørsler om O4-mini-høy per dag

* 100 O3-forespørsler per uke

* 15 O3-Pro-forespørsler per måned

FAQ-artikkelen nevnte også at de nåværende begrensningene til GPT-5 Thinking-modellen er midlertidige og faktisk er høyere enn de langsiktige grensene som er oppført ovenfor.

Tibor Blaho14. aug., 03:17

For alle som spør om grensene for ChatGPT Team & Enterprise - det er 2 nye FAQ-artikler

- ChatGPT Team - ubegrenset GPT-5 og GPT-4o, 200 GPT-5 Thinking-forespørsler/dag, 2800 GPT-5 Thinking mini-forespørsler/uke, 15 GPT-5 Pro-forespørsler/måned, 500 GPT-4.1-forespørsler/3 timer, 300 o4-mini- og o3-forespørsler/dag

- ChatGPT Enterprise - ubegrenset GPT-5, GPT-4o og GPT-4.1-mini, 200 GPT-5 Thinking-forespørsler/uke, 15 GPT-5 Pro-forespørsler/måned, 20 GPT-4.5-forespørsler/uke, 500 GPT-4.1-forespørsler/3 timer, 300 o4-mini-mini-forespørsler/dag, 100 o4-mini-high-forespørsler/dag, 100 o3-forespørsler/uke, 15 o3-pro-forespørsler/måned

FAQ-artikkelen nevner at GPT-5 Thinking-grensene er midlertidig høyere enn de langsiktige rentene vist ovenfor

15,53K

Dette er sant: mindre i oppfordringen til å si hva du ikke skal gjøre, men hva du skal gjøre. Den store modellen er veldig lik mennesker, og jo mer du ikke lar den gjøre, jo lettere er det å tiltrekke seg oppmerksomhet

素人极客-Amateur Geek13. aug., 23:50

Når du vil gjøre modellen forbudt eller ikke,

Prøv å ikke skrive direkte!!

Prøv å ikke skrive direkte!!

Prøv å ikke skrive direkte!!

Her er noen enkle metoder:

1. Skriv mer enn to

2. Gjør det du ikke vil ha til ønske. Ikke skriv syke setninger - du må sjekke setning for setning for å sikre forvarsel, start og sammenheng før og etter hver setning

3. Forbudt innhold fra forbudt til flere opptredener. Noen ting kan ikke huskes når de først er sagt. Da jeg gikk på skolen, sa min japanske utenlandslærer at det er et spesielt sted i japanske selskaper som vil ta seg bryet med å forklare en enkel ting slik at du ikke glemmer, selv de minste tingene, hvis du nevner dem mange ganger, vil de bli husket. Du kan utestenge i begynnelsen, i midten, der det er relatert, og på slutten.

4. Forbudet er ikke å gjøre det, legg deretter til ett trinn, fullfør en ting om gangen, gjør det om til to trinn, legg til en setning på slutten, la deg fullføre handlingene ovenfor, spør meg om det er noen forbudte gjenstander, jeg sender deg de forbudte gjenstandene, og så begynner vi å skjerme de forbudte gjenstandene, og når du delvis endrer, sørg for at annen informasjon forblir uendret.

5. Sett de forbudte gjenstandene i det første trinnet.

6. Avgjør om forbudene dine kan forbys. For eksempel, hvis du ikke bestemmer stilen til tekstforfatteren, og teksten har en AI-smak, så er det nytteløst for deg å forby ham å bruke AI-tone, og han vet ikke hvilken tone han bruker!

63,86K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til