Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

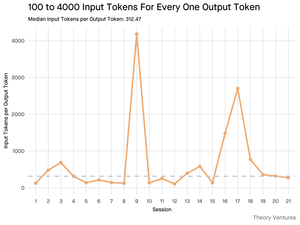

Když se dotazujete na umělou inteligenci, shromažďuje relevantní informace, aby vám mohla odpovědět.

Kolik informací však model potřebuje?

Rozhovory s praktiky odhalily jejich intuici: vstup byl ~20x větší než výstup.

Ale moje experimenty s rozhraním příkazového řádku nástroje Gemini, které vypisuje podrobné statistiky tokenů, odhalily jeho mnohem vyšší.

V průměru 300x a až 4000x.

Zde je důvod, proč je tento vysoký poměr vstupů a výstupů důležitý pro každého, kdo vytváří s umělou inteligencí:

Řízení nákladů je především o vstupu. U volání rozhraní API s cenou za token znamená poměr 300:1, že náklady jsou diktovány kontextem, nikoli odpovědí. Tato cenová dynamika platí pro všechny hlavní modely.

Na stránce s cenami OpenAI jsou výstupní tokeny pro GPT-4.1 4x dražší než vstupní tokeny. Když je však vstup 300x objemnější, vstupní náklady stále tvoří 98 % z celkového účtu.

Latence je funkcí velikosti kontextu. Důležitým faktorem určujícím, jak dlouho bude uživatel čekat na odpověď, je doba, za kterou model zpracuje vstup.

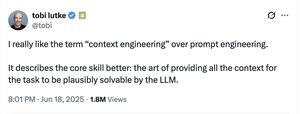

Nově definuje inženýrskou výzvu. Toto pozorování dokazuje, že hlavní výzvou budování s LLM není jen pobídnutí. Je to kontextové inženýrství.

Kritickým úkolem je vytvoření efektivního získávání dat a kontextu - vytváření kanálů, které dokážou najít nejlepší informace a destilovat je do co nejmenší stopy tokenu.

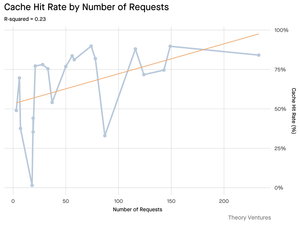

Ukládání do mezipaměti se stává kritickým. Pokud je 99 % tokenů ve vstupu, vybudování robustní cachovací vrstvy pro často stahované dokumenty nebo běžné kontexty dotazů se posouvá od "příjemného řešení" k základnímu architektonickému požadavku pro vytvoření nákladově efektivního a škálovatelného produktu.

Pro vývojáře to znamená, že zaměření na optimalizaci vstupů je kritickou pákou pro kontrolu nákladů, snížení latence a v konečném důsledku pro vytvoření úspěšného produktu poháněného umělou inteligencí.

4,23K

Top

Hodnocení

Oblíbené