トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

AIにクエリを実行すると、AIはあなたに答えるための関連情報を収集します。

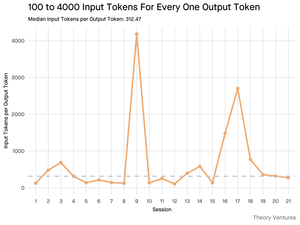

しかし、モデルにはどのくらいの情報が必要ですか?

実務家との会話から、彼らの直感が明らかになりました:インプットはアウトプットよりも~20倍大きかったのです。

しかし、詳細なトークン統計を出力するGeminiツールのコマンドラインインターフェイスを使用した私の実験では、はるかに高いことが明らかになりました。

平均で300倍、最大4000倍。

この高いインプットとアウトプットの比率が、AI を使用して構築する人にとって重要である理由は次のとおりです。

コスト管理は、インプットがすべてです。APIコールがトークンごとに価格設定されている場合、300:1の比率は、コストが答えではなくコンテキストによって決定されることを意味します。この価格設定のダイナミクスは、すべての主要なモデルに当てはまります。

OpenAIの価格ページでは、GPT-4.1の出力トークンは入力トークンの4倍の価格です。しかし、インプットが300倍膨大であっても、インプットコストは総請求額の98%にとどまります。

レイテンシはコンテキストサイズの関数です。ユーザーが回答を待つ時間を決定する重要な要素は、モデルが入力を処理するのにかかる時間です。

エンジニアリングの課題を再定義します。この観察は、LLMを使用して構築する際の主要な課題は、単に促すことではないことを証明しています。それはコンテクストエンジニアリングです。

重要なタスクは、効率的なデータ取得とコンテキストを構築すること、つまり、最適な情報を見つけ出し、それを可能な限り最小のトークンフットプリントに抽出できるパイプラインを作成することです。

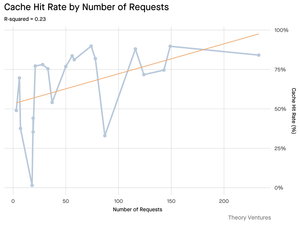

キャッシングはミッションクリティカルになります。トークンの99%が入力に含まれている場合、頻繁に取得されるドキュメントや一般的なクエリコンテキストのための堅牢なキャッシングレイヤーを構築することは、「あれば便利」なものから、費用対効果が高くスケーラブルな製品を構築するための中核的なアーキテクチャ要件に移行します。

開発者にとって、入力の最適化に焦点を当てることは、コストを管理し、レイテンシを削減し、最終的にはAIを活用した製品を成功させるための重要な手段であることを意味します。

4.21K

トップ

ランキング

お気に入り