Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Når du spør AI, samler den relevant informasjon for å svare deg.

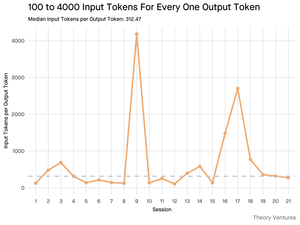

Men hvor mye informasjon trenger modellen?

Samtaler med utøvere avslørte deres intuisjon: inngangen var ~20 ganger større enn utgangen.

Men eksperimentene mine med Gemini-verktøyets kommandolinjegrensesnitt, som sender ut detaljert token-statistikk, avslørte at det er mye høyere.

300x i gjennomsnitt og opptil 4000x.

Her er grunnen til at dette høye input-to-output-forholdet er viktig for alle som bygger med AI:

Kostnadsstyring handler om input. Med API-kall priset per token, betyr et forhold på 300:1 at kostnadene dikteres av konteksten, ikke svaret. Denne prisdynamikken gjelder på tvers av alle større modeller.

På OpenAIs prisside er utgangstokens for GPT-4.1 4 ganger så dyre som inngangstokens. Men når innsatsen er 300 ganger mer omfangsrik, er innsatskostnadene fortsatt 98 % av den totale regningen.

Latens er en funksjon av kontekststørrelse. En viktig faktor som bestemmer hvor lenge en bruker venter på et svar, er tiden det tar modellen å behandle inndataene.

Det omdefinerer den tekniske utfordringen. Denne observasjonen beviser at kjerneutfordringen med å bygge med LLM-er ikke bare er tilskyndende. Det er kontekstteknikk.

Den kritiske oppgaven er å bygge effektiv datainnhenting og kontekst - lage pipelines som kan finne den beste informasjonen og destillere den til minst mulig token-fotavtrykk.

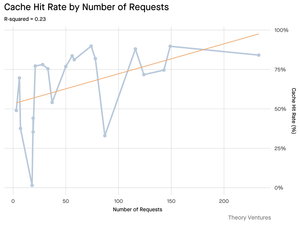

Bufring blir virksomhetskritisk. Hvis 99 % av tokenene er i inndataene, flyttes det å bygge et robust hurtigbufredlag for ofte hentede dokumenter eller vanlige spørringskontekster fra å være et «kjekt å ha» til et kjernearkitektonisk krav for å bygge et kostnadseffektivt og skalerbart produkt.

For utviklere betyr dette at fokus på inngangsoptimalisering er en kritisk spak for å kontrollere kostnader, redusere ventetid og til slutt bygge et vellykket AI-drevet produkt.

4,21K

Topp

Rangering

Favoritter