Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Wenn Sie KI abfragen, sammelt sie relevante Informationen, um Ihnen zu antworten.

Aber wie viele Informationen benötigt das Modell?

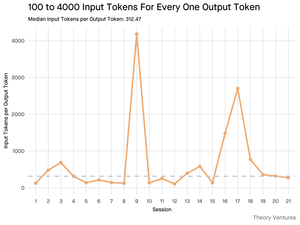

Gespräche mit Praktikern haben deren Intuition offenbart: Der Input war ~20x größer als der Output.

Aber meine Experimente mit der Gemini-Tool-Befehlszeilenschnittstelle, die detaillierte Token-Statistiken ausgibt, haben gezeigt, dass es viel höher ist.

Im Durchschnitt 300x und bis zu 4000x.

Hier ist, warum dieses hohe Verhältnis von Input zu Output für jeden, der mit KI arbeitet, wichtig ist:

Kostenmanagement dreht sich ganz um den Input. Bei API-Aufrufen, die pro Token berechnet werden, bedeutet ein Verhältnis von 300:1, dass die Kosten durch den Kontext und nicht durch die Antwort bestimmt werden. Diese Preisgestaltung gilt für alle großen Modelle.

Auf der Preisübersicht von OpenAI sind die Output-Token für GPT-4.1 4x so teuer wie die Input-Token. Aber wenn der Input 300x voluminöser ist, machen die Input-Kosten immer noch 98% der Gesamtrechnung aus.

Latenz ist eine Funktion der Kontextgröße. Ein wichtiger Faktor, der bestimmt, wie lange ein Benutzer auf eine Antwort wartet, ist die Zeit, die das Modell benötigt, um den Input zu verarbeiten.

Es definiert die Ingenieurausforderung neu. Diese Beobachtung beweist, dass die zentrale Herausforderung beim Bauen mit LLMs nicht nur im Prompting besteht. Es geht um Kontextengineering.

Die entscheidende Aufgabe besteht darin, effiziente Datenabruf- und Kontextpipelines zu erstellen, die die besten Informationen finden und sie in den kleinsten möglichen Token-Fußabdruck destillieren.

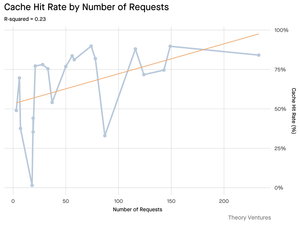

Caching wird mission-kritisch. Wenn 99% der Tokens im Input sind, wird der Aufbau einer robusten Caching-Schicht für häufig abgerufene Dokumente oder gängige Abfragekontexte von einem "Nice-to-have" zu einer grundlegenden architektonischen Anforderung für den Aufbau eines kosteneffizienten und skalierbaren Produkts.

Für Entwickler bedeutet dies, dass der Fokus auf der Optimierung des Inputs ein kritischer Hebel zur Kostenkontrolle, zur Reduzierung der Latenz und letztendlich zum Aufbau eines erfolgreichen KI-gestützten Produkts ist.

4,22K

Top

Ranking

Favoriten