Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Quando interroghi l'IA, essa raccoglie informazioni rilevanti per risponderti.

Ma, quante informazioni ha bisogno il modello?

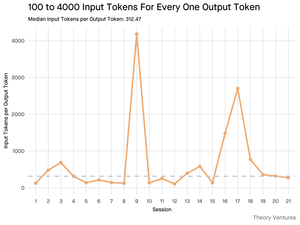

Le conversazioni con i professionisti hanno rivelato la loro intuizione: l'input era ~20 volte più grande dell'output.

Ma i miei esperimenti con l'interfaccia a riga di comando dello strumento Gemini, che fornisce statistiche dettagliate sui token, hanno rivelato che è molto più alto.

In media 300 volte e fino a 4000 volte.

Ecco perché questo alto rapporto input-output è importante per chiunque stia costruendo con l'IA:

La gestione dei costi riguarda tutto l'input. Con le chiamate API prezzate per token, un rapporto di 300:1 significa che i costi sono dettati dal contesto, non dalla risposta. Questa dinamica di prezzo è valida per tutti i principali modelli.

Nella pagina dei prezzi di OpenAI, i token di output per GPT-4.1 costano 4 volte di più dei token di input. Ma quando l'input è 300 volte più voluminoso, i costi di input rappresentano ancora il 98% della bolletta totale.

La latenza è una funzione della dimensione del contesto. Un fattore importante che determina quanto tempo un utente aspetta per una risposta è il tempo necessario al modello per elaborare l'input.

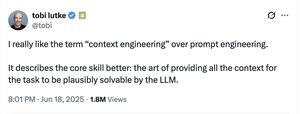

Ridefinisce la sfida ingegneristica. Questa osservazione dimostra che la sfida principale di costruire con i LLM non è solo il prompting. È l'ingegneria del contesto.

Il compito critico è costruire un recupero dati efficiente e contesto - creare pipeline che possano trovare le migliori informazioni e distillarle nel minor numero possibile di token.

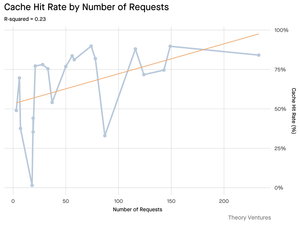

Il caching diventa mission-critical. Se il 99% dei token è nell'input, costruire uno strato di caching robusto per documenti frequentemente recuperati o contesti di query comuni passa da un "nice-to-have" a un requisito architettonico fondamentale per costruire un prodotto scalabile e conveniente.

Per gli sviluppatori, questo significa che concentrarsi sull'ottimizzazione dell'input è una leva critica per controllare i costi, ridurre la latenza e, in ultima analisi, costruire un prodotto di successo alimentato dall'IA.

4,22K

Principali

Ranking

Preferiti