Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Quando você consulta a IA, ela reúne informações relevantes para responder.

Mas, quanta informação o modelo precisa?

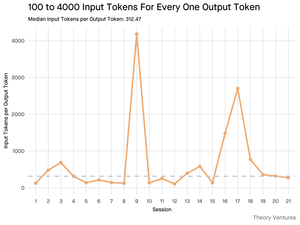

Conversas com os praticantes revelaram a intuição deles: a entrada foi ~ 20x maior que a saída.

Mas meus experimentos com a interface de linha de comando da ferramenta Gemini, que gera estatísticas detalhadas de tokens, revelaram que é muito maior.

300x em média e até 4000x.

Veja por que essa alta relação de entrada e saída é importante para quem constrói com IA:

O gerenciamento de custos tem tudo a ver com a entrada. Com chamadas de API precificadas por token, uma proporção de 300:1 significa que os custos são ditados pelo contexto, não pela resposta. Essa dinâmica de preços é verdadeira em todos os principais modelos.

Na página de preços da OpenAI, os tokens de saída para GPT-4.1 são 4x mais caros que os tokens de entrada. Mas quando a entrada é 300 vezes mais volumosa, os custos de entrada ainda são 98% da conta total.

A latência é uma função do tamanho do contexto. Um fator importante que determina quanto tempo um usuário espera por uma resposta é o tempo que o modelo leva para processar a entrada.

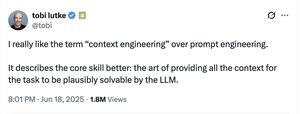

Ele redefine o desafio da engenharia. Essa observação prova que o principal desafio de construir com LLMs não é apenas solicitar. É engenharia de contexto.

A tarefa crítica é construir recuperação de dados e contexto eficientes - criando pipelines que possam encontrar as melhores informações e destilá-las na menor pegada de token possível.

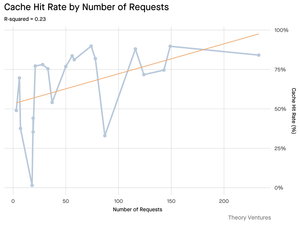

O cache torna-se de missão crítica. Se 99% dos tokens estiverem na entrada, a criação de uma camada de cache robusta para documentos recuperados com frequência ou contextos de consulta comuns passa de um "bom ter" para um requisito de arquitetura central para a construção de um produto econômico e escalável.

Para os desenvolvedores, isso significa que focar na otimização de entrada é uma alavanca crítica para controlar custos, reduzir a latência e, por fim, criar um produto bem-sucedido com inteligência artificial.

4,24K

Melhores

Classificação

Favoritos