Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Lorsque vous interrogez l'IA, elle rassemble des informations pertinentes pour vous répondre.

Mais, combien d'informations le modèle a-t-il besoin ?

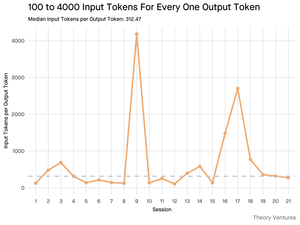

Les conversations avec des praticiens ont révélé leur intuition : l'entrée était ~20x plus grande que la sortie.

Mais mes expériences avec l'interface de ligne de commande de l'outil Gemini, qui fournit des statistiques détaillées sur les tokens, ont révélé que c'était beaucoup plus élevé.

300x en moyenne et jusqu'à 4000x.

Voici pourquoi ce rapport élevé entrée-sortie est important pour quiconque construit avec l'IA :

La gestion des coûts dépend entièrement de l'entrée. Avec des appels API tarifés par token, un ratio de 300:1 signifie que les coûts sont dictés par le contexte, pas par la réponse. Cette dynamique de tarification est valable pour tous les principaux modèles.

Sur la page de tarification d'OpenAI, les tokens de sortie pour GPT-4.1 sont 4x plus chers que les tokens d'entrée. Mais lorsque l'entrée est 300x plus volumineuse, les coûts d'entrée représentent toujours 98% de la facture totale.

La latence est une fonction de la taille du contexte. Un facteur important déterminant combien de temps un utilisateur attend une réponse est le temps nécessaire au modèle pour traiter l'entrée.

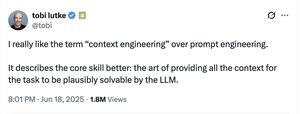

Cela redéfinit le défi d'ingénierie. Cette observation prouve que le défi principal de la construction avec les LLM n'est pas seulement de donner des instructions. C'est l'ingénierie du contexte.

La tâche critique consiste à construire une récupération de données efficace et un contexte - créer des pipelines capables de trouver les meilleures informations et de les distiller dans l'empreinte de token la plus petite possible.

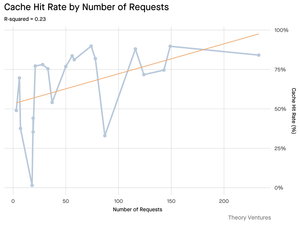

Le caching devient essentiel. Si 99% des tokens se trouvent dans l'entrée, construire une couche de caching robuste pour les documents fréquemment récupérés ou les contextes de requête courants passe d'un "nice-to-have" à une exigence architecturale fondamentale pour construire un produit rentable et évolutif.

Pour les développeurs, cela signifie que se concentrer sur l'optimisation de l'entrée est un levier critique pour contrôler les coûts, réduire la latence et, en fin de compte, construire un produit alimenté par l'IA réussi.

4,23K

Meilleurs

Classement

Favoris