Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Quando você consulta a IA, ela reúne informações relevantes para te responder.

Mas, quanta informação o modelo precisa?

Conversas com profissionais revelaram a sua intuição: a entrada era ~20x maior que a saída.

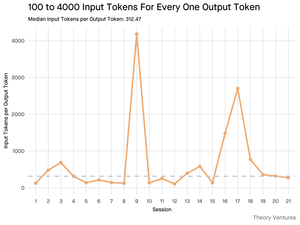

Mas meus experimentos com a interface de linha de comando da ferramenta Gemini, que fornece estatísticas detalhadas de tokens, revelaram que é muito maior.

300x em média e até 4000x.

Aqui está o porquê dessa alta relação entrada-saída ser importante para quem está construindo com IA:

A Gestão de Custos é Tudo Sobre a Entrada. Com chamadas de API precificadas por token, uma relação de 300:1 significa que os custos são ditados pelo contexto, não pela resposta. Essa dinâmica de preços se mantém verdadeira em todos os principais modelos.

Na página de preços da OpenAI, os tokens de saída para o GPT-4.1 são 4x mais caros que os tokens de entrada. Mas quando a entrada é 300x mais volumosa, os custos de entrada ainda representam 98% da conta total.

A Latência é uma Função do Tamanho do Contexto. Um fator importante que determina quanto tempo um usuário espera por uma resposta é o tempo que o modelo leva para processar a entrada.

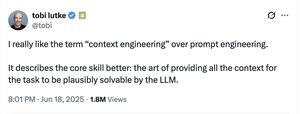

Isso Redefine o Desafio de Engenharia. Essa observação prova que o desafio central de construir com LLMs não é apenas a solicitação. É a engenharia de contexto.

A tarefa crítica é construir recuperação de dados eficiente e contexto - criando pipelines que podem encontrar as melhores informações e destilá-las na menor pegada de token possível.

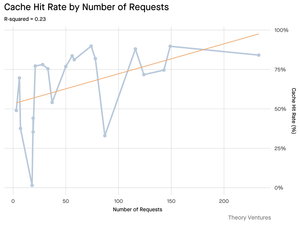

O Cache Torna-se Crítico. Se 99% dos tokens estão na entrada, construir uma camada de cache robusta para documentos frequentemente recuperados ou contextos de consulta comuns passa de um "bom de ter" para um requisito arquitetônico central para construir um produto escalável e econômico.

Para os desenvolvedores, isso significa que focar na otimização da entrada é uma alavanca crítica para controlar custos, reduzir latência e, em última análise, construir um produto bem-sucedido alimentado por IA.

4,22K

Top

Classificação

Favoritos