熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

當你查詢 AI 時,它會收集相關資訊來回答你。

但是,模型需要多少資訊呢?

與從業者的對話揭示了他們的直覺:輸入大約是輸出的 20 倍。

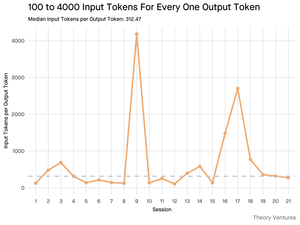

但我使用 Gemini 工具的命令行介面進行的實驗顯示,這個比例要高得多。

平均為 300 倍,最高可達 4000 倍。

這麼高的輸入與輸出比率對於任何使用 AI 的人來說都很重要,原因如下:

成本管理完全取決於輸入。由於 API 調用按每個標記定價,300:1 的比例意味著成本由上下文決定,而不是答案。這種定價動態在所有主要模型中都成立。

在 OpenAI 的定價頁面上,GPT-4.1 的輸出標記價格是輸入標記的 4 倍。但當輸入的體積是 300 倍時,輸入成本仍然佔總帳單的 98%。

延遲是上下文大小的函數。決定用戶等待答案的時間的一個重要因素是模型處理輸入所需的時間。

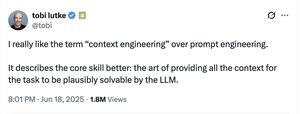

它重新定義了工程挑戰。這一觀察證明,使用 LLMs 的核心挑戰不僅僅是提示,而是上下文工程。

關鍵任務是建立高效的數據檢索和上下文——打造能夠找到最佳資訊並將其提煉成最小標記足跡的管道。

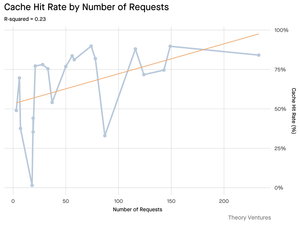

緩存變得至關重要。如果 99% 的標記都在輸入中,為經常檢索的文檔或常見查詢上下文建立穩健的緩存層,從「可有可無」變成了構建成本效益高且可擴展產品的核心架構要求。

對於開發者來說,這意味著專注於輸入優化是控制成本、減少延遲以及最終構建成功的 AI 驅動產品的關鍵杠杆。

4.21K

熱門

排行

收藏