Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Cuando consulta a la IA, recopila información relevante para responderle.

Pero, ¿cuánta información necesita el modelo?

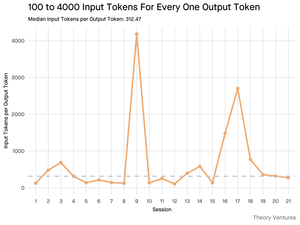

Las conversaciones con los practicantes revelaron su intuición: la entrada era ~ 20 veces mayor que la salida.

Pero mis experimentos con la interfaz de línea de comandos de la herramienta Gemini, que genera estadísticas detalladas de tokens, revelaron que es mucho más alta.

300x en promedio y hasta 4000x.

He aquí por qué esta alta relación entrada-salida es importante para cualquiera que construya con IA:

La gestión de costos tiene que ver con la entrada. Con las llamadas a la API con un precio por token, una proporción de 300:1 significa que los costos están dictados por el contexto, no por la respuesta. Esta dinámica de precios se mantiene en todos los modelos principales.

En la página de precios de OpenAI, los tokens de salida para GPT-4.1 son 4 veces más caros que los tokens de entrada. Pero cuando el insumo es 300 veces más voluminoso, los costos de los insumos siguen siendo el 98% de la factura total.

La latencia es una función del tamaño del contexto. Un factor importante que determina cuánto tiempo espera un usuario una respuesta es el tiempo que tarda el modelo en procesar la entrada.

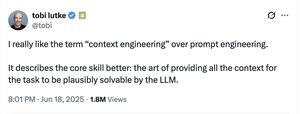

Redefine el desafío de ingeniería. Esta observación demuestra que el desafío central de construir con LLM no es solo la incitación. Es ingeniería de contexto.

La tarea crítica es crear una recuperación de datos y un contexto eficientes, creando canalizaciones que puedan encontrar la mejor información y destilarla en la menor huella de token posible.

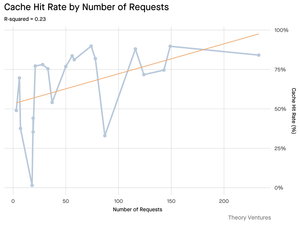

El almacenamiento en caché se convierte en una misión crítica. Si el 99% de los tokens están en la entrada, la creación de una capa de almacenamiento en caché sólida para documentos recuperados con frecuencia o contextos de consulta comunes pasa de ser un requisito arquitectónico "agradable de tener" a un requisito arquitectónico central para crear un producto rentable y escalable.

Para los desarrolladores, esto significa que centrarse en la optimización de entradas es una palanca fundamental para controlar los costos, reducir la latencia y, en última instancia, crear un producto exitoso impulsado por IA.

4.2K

Populares

Ranking

Favoritas