Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Когда вы запрашиваете ИИ, он собирает соответствующую информацию, чтобы ответить вам.

Но сколько информации нужно модели?

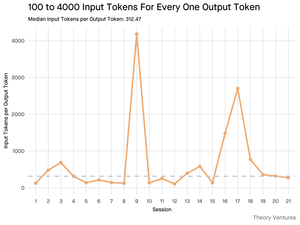

Беседы с практиками показали их интуицию: входные данные были примерно в 20 раз больше, чем выходные.

Но мои эксперименты с интерфейсом командной строки инструмента Gemini, который выводит подробную статистику токенов, показали, что это гораздо больше.

В среднем 300 раз и до 4000 раз.

Вот почему это высокое соотношение входных и выходных данных имеет значение для всех, кто строит с ИИ:

Управление затратами зависит от входных данных. Поскольку вызовы API оцениваются по токенам, соотношение 300:1 означает, что затраты определяются контекстом, а не ответом. Эта ценовая динамика верна для всех основных моделей.

На странице цен OpenAI выходные токены для GPT-4.1 в 4 раза дороже входных токенов. Но когда входные данные в 300 раз более объемные, затраты на входные данные все равно составляют 98% от общего счета.

Задержка зависит от размера контекста. Важным фактором, определяющим, сколько времени пользователь ждет ответа, является время, необходимое модели для обработки входных данных.

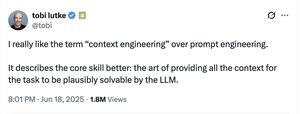

Это переопределяет инженерную задачу. Это наблюдение доказывает, что основной вызов при работе с LLM не только в том, чтобы задавать вопросы. Это инженерия контекста.

Критическая задача заключается в создании эффективного извлечения данных и контекста - разработке конвейеров, которые могут находить лучшую информацию и сжимать ее до минимального возможного объема токенов.

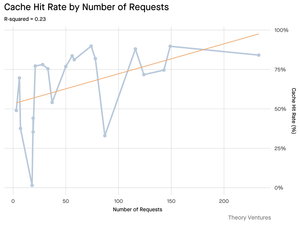

Кэширование становится критически важным. Если 99% токенов находятся во входных данных, создание надежного кэширования для часто запрашиваемых документов или общих контекстов запросов переходит из разряда "желательно иметь" в основное архитектурное требование для создания экономически эффективного и масштабируемого продукта.

Для разработчиков это означает, что сосредоточение на оптимизации входных данных является критическим рычагом для контроля затрат, снижения задержки и, в конечном итоге, создания успешного продукта на базе ИИ.

4,25K

Топ

Рейтинг

Избранное