热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

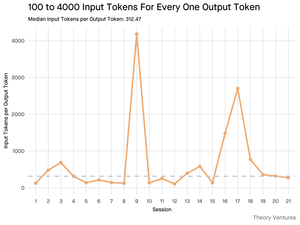

当你查询AI时,它会收集相关信息来回答你。

但是,模型需要多少信息呢?

与从业者的对话揭示了他们的直觉:输入大约是输出的20倍。

但我使用Gemini工具命令行界面进行的实验显示,这个比例要高得多。

平均300倍,最高可达4000倍。

以下是这个高输入与输出比率对任何与AI构建相关的人来说的重要性:

成本管理完全取决于输入。由于API调用按令牌计费,300:1的比例意味着成本由上下文决定,而不是答案。这个定价动态在所有主要模型中都适用。

在OpenAI的定价页面上,GPT-4.1的输出令牌价格是输入令牌的4倍。但当输入的体量是300倍时,输入成本仍占总账单的98%。

延迟是上下文大小的函数。决定用户等待答案时间的重要因素是模型处理输入所需的时间。

它重新定义了工程挑战。这一观察证明,使用LLM构建的核心挑战不仅仅是提示,而是上下文工程。

关键任务是构建高效的数据检索和上下文——设计能够找到最佳信息并将其提炼成尽可能小的令牌足迹的管道。

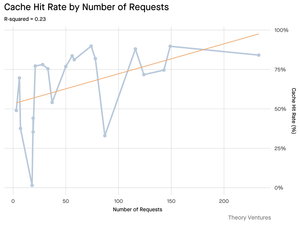

缓存变得至关重要。如果99%的令牌在输入中,为频繁检索的文档或常见查询上下文构建一个强大的缓存层,从“可有可无”变成了构建一个具有成本效益和可扩展产品的核心架构要求。

对于开发者来说,这意味着关注输入优化是控制成本、减少延迟以及最终构建成功的AI驱动产品的关键杠杆。

4.22K

热门

排行

收藏