المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

يمكن التعلم المعزز LLMs من التغلب على البشر في مسابقات البرمجة / الرياضيات وقد أدى إلى التطورات الحديثة (سلسلة O من OpenAI ، Anthropic's Claude 4)

هل ستمكن RL من التعميم الواسع بنفس الطريقة التي يعمل بها التدريب المسبق؟ ليس مع التقنيات الحالية

🧵 1/7

🔗الروابط هنا والموضوع أدناه:

ورق:

متوسط:

Substack:

2/7

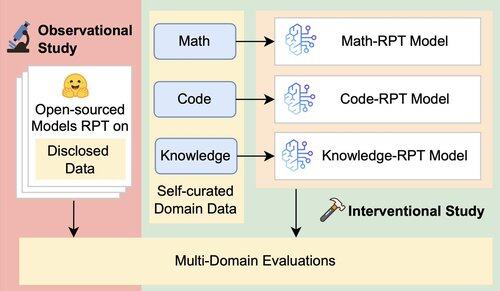

يقوم التقييم الحالي لطلاب القانون بتقييم الأداء في المجال بشكل أساسي ، باستخدام نماذج ما بعد التدريب المعزز (RPT) المدربة على بيانات المجالات المختلطة وتقييمها على معايير تتماشى بشكل وثيق مع مجالات التدريب الخاصة بهم. تقدم هذه الإعدادات عوامل مربكة تحجب المدى الحقيقي لقدرة التعميم ل RPT

3/7

نقدم إطار عمل تقييم موحد يعزل ويختبر التعميم عبر المجالات ل RPT باستخدام 16 معيارا عبر الرياضيات والتعليمات البرمجية والتفكير كثيف المعرفة. في هذا الإطار ، نقوم بتقييم مجموعات مختلفة من النماذج الأساسية واستراتيجيات RPT

4/7

📌 النتائج الرئيسية التي توصلنا إليها:

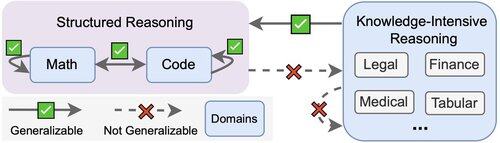

1️⃣ مكاسب RPT هي في الغالب في المجال

2️⃣ الرياضيات والتعليمات البرمجية تعميم جيدا لبعضها البعض

3️⃣ لا تنتقل المهارات المنظمة إلى مهام غير منظمة وكثيفة المعرفة

5/7

الوجبات الجاهزة؟ RPT قوي ولكنه ضيق

يحسن الأداء حيث يتم تدريبه ، ولكنه يعمم بشكل سيئ

6/7

هذا العمل مشترك مع @ChuxuanHu و @maxYuxuanZhu و @aokellermann و Caleb Biddulph و @PunWai و @jasoncbenn

7/7

2.62K

الأفضل

المُتصدِّرة

التطبيقات المفضلة