Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

L'apprendimento per rinforzo consente ai LLM di battere gli esseri umani nelle competizioni di programmazione/matematica e ha guidato i recenti progressi (la serie o di OpenAI, Claude 4 di Anthropic)

L'apprendimento per rinforzo permetterà una generalizzazione ampia nello stesso modo in cui lo fa il pre-addestramento? Non con le tecniche attuali

🧵 1/7

🔗Link qui e thread qui sotto:

Carta:

Medium:

Substack:

2/7

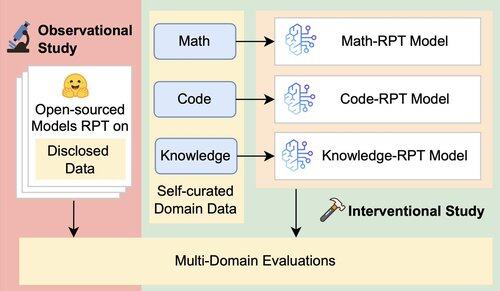

La valutazione esistente per i LLM si concentra principalmente sulle prestazioni in dominio, utilizzando modelli di rinforzo post-addestramento (RPT) addestrati su dati di dominio misto e valutati su benchmark strettamente allineati con i loro domini di addestramento. Questi set-up introducono fattori confondenti che offuscano la vera estensione della capacità di generalizzazione di RPT

3/7

Introduciamo un framework di valutazione unificato che isola e testa la generalizzazione cross-domain di RPT utilizzando 16 benchmark in matematica, codice e ragionamento intensivo di conoscenza. All'interno di questo framework, valutiamo varie combinazioni di modelli di base e strategie RPT

4/7

📌 I nostri risultati principali:

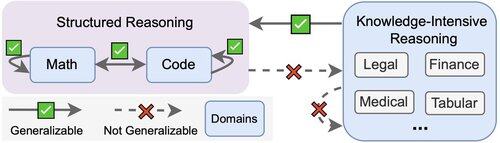

1️⃣ I guadagni RPT sono per lo più nel dominio

2️⃣ La matematica e il codice si generalizzano bene l'uno con l'altro

3️⃣ Le competenze strutturate non si trasferiscono a compiti non strutturati e ad alta intensità di conoscenza

5/7

La conclusione? RPT è potente ma ristretto

Migliora le prestazioni dove è addestrato, ma generalizza male

6/7

Questo lavoro è stato realizzato con @ChuxuanHu, @maxYuxuanZhu, @aokellermann, Caleb Biddulph, @PunWai e @jasoncbenn

7/7

2,61K

Principali

Ranking

Preferiti