Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Zpětnovazební učení umožňuje LLM porážet lidi v programovacích/matematických soutěžích a je hnacím motorem nedávných pokroků (o-série OpenAI, Claude 4 od Anthropic)

Umožní RL široké zobecnění stejným způsobem jako předtrénování? Ne se současnými technikami

🧵 1/7

🔗Odkazy zde a vlákno níže:

Papír:

Středně:

Dílčí zásobník:

2/7

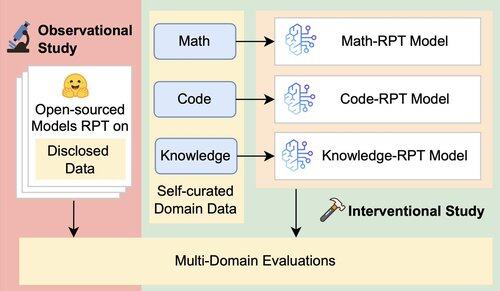

Stávající hodnocení pro LLM primárně hodnotí výkonnost v doméně pomocí modelů po trénování (RPT) trénovaných na datech ve smíšených doménách a hodnocených na benchmarkech úzce sladěných s jejich trénovacími doménami. Tato nastavení zavádějí matoucí faktory, které zastírají skutečný rozsah schopnosti RPT zobecňovat

3/7

Zavádíme jednotný vyhodnocovací rámec, který izoluje a testuje mezidoménové zobecnění RPT pomocí 16 benchmarků napříč matematickým, kódovým a znalostním uvažováním. V tomto rámci vyhodnocujeme různé kombinace základních modelů a RPT strategií

4/7

📌 Naše klíčová zjištění:

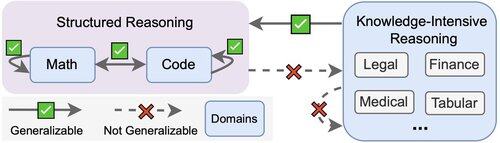

1️⃣ Zisky z RPT jsou většinou v doméně

2️⃣ Matematika a kód se navzájem dobře zobecňují

3️⃣ Strukturované dovednosti se nepřenášejí na nestrukturované, znalosti náročné úkoly

5/7

Co si z toho odnést? RPT je výkonný, ale úzký

Zlepšuje výkon tam, kde je trénován, ale špatně zobecňuje

6/7

Tato práce je společná s @ChuxuanHu, @maxYuxuanZhu, @aokellermann, Calebem Biddulphem, @PunWai a @jasoncbenn

7/7

2,59K

Top

Hodnocení

Oblíbené