Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Pembelajaran penguatan memungkinkan LLM untuk mengalahkan manusia dalam kompetisi pemrograman/matematika dan telah mendorong kemajuan baru-baru ini (seri o OpenAI, Claude 4 dari Anthropic)

Akankah RL memungkinkan generalisasi luas dengan cara yang sama seperti prapelatihan? Tidak dengan teknik saat ini

🧵 1/7

🔗Tautan di sini dan utas di bawah ini:

Kertas:

Sedang:

Subtumpukan:

2/7

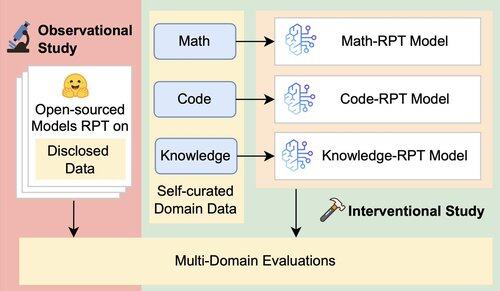

Evaluasi yang ada untuk LLM terutama menilai kinerja dalam domain, menggunakan model pasca-pelatihan penguatan (RPT) yang dilatih pada data domain campuran dan dievaluasi pada tolok ukur yang selaras erat dengan domain pelatihan mereka. Pengaturan ini memperkenalkan faktor yang membingungkan yang mengaburkan sejauh mana kemampuan generalisasi RPT yang sebenarnya

3/7

Kami memperkenalkan kerangka kerja evaluasi terpadu yang mengisolasi dan menguji generalisasi lintas domain RPT menggunakan 16 tolok ukur di seluruh matematika, kode, dan penalaran intensif pengetahuan. Dalam kerangka kerja ini, kami mengevaluasi berbagai kombinasi model dasar dan strategi RPT

4/7

📌 Temuan utama kami:

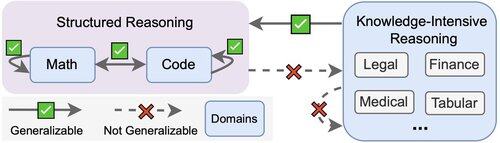

1️⃣ Keuntungan RPT sebagian besar berada dalam domain

2️⃣ Matematika & kode menggeneralisasi dengan baik satu sama lain

3️⃣ Keterampilan terstruktur tidak ditransfer ke tugas yang tidak terstruktur dan intensif pengetahuan

5/7

Kesimpulannya? RPT kuat tapi sempit

Ini meningkatkan kinerja di mana ia dilatih, tetapi menggeneralisasi dengan buruk

6/7

Karya ini digabungkan dengan @ChuxuanHu, @maxYuxuanZhu, @aokellermann, Caleb Biddulph, @PunWai, dan @jasoncbenn

7/7

2,6K

Teratas

Peringkat

Favorit