Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Uczenie przez wzmocnienie umożliwia LLM-om pokonywanie ludzi w konkursach programistycznych/matematycznych i przyczyniło się do ostatnich postępów (o-seria OpenAI, Claude 4 Anthropic)

Czy RL umożliwi szeroką generalizację w taki sam sposób, jak pretrening? Nie z obecnymi technikami

🧵 1/7

🔗Linki tutaj i wątek poniżej:

Dokument:

Medium:

Substack:

2/7

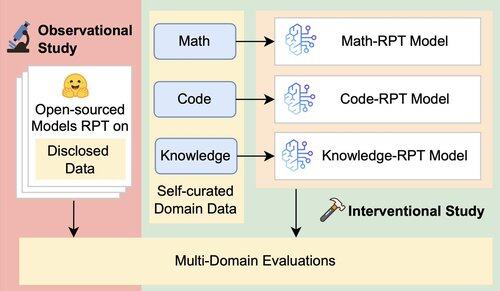

Istniejąca ocena LLM-ów głównie ocenia wydajność w danym obszarze, wykorzystując modele RPT (reinforcement post-training) trenowane na danych z różnych dziedzin i oceniane na podstawie benchmarków ściśle związanych z ich dziedzinami treningowymi. Te ustawienia wprowadzają czynniki zakłócające, które zaciemniają prawdziwy zakres zdolności generalizacji RPT

3/7

Wprowadzamy zjednoczoną ramę oceny, która izoluje i testuje ogólną zdolność RPT do działania w różnych dziedzinach, wykorzystując 16 benchmarków w obszarach matematyki, kodowania i rozumowania opartego na wiedzy. W ramach tej struktury oceniamy różne kombinacje modeli bazowych i strategii RPT

4/7

📌 Nasze najważniejsze wnioski:

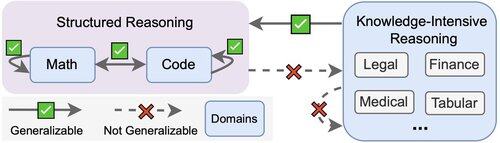

1️⃣ Zyski RPT są głównie w domenie

2️⃣ Matematyka i kod dobrze się uogólniają

3️⃣ Ustrukturyzowane umiejętności nie przenoszą się do nieustrukturyzowanych, wymagających wiedzy zadań

5/7

Wnioski? RPT jest potężny, ale wąski

Poprawia wydajność tam, gdzie jest trenowany, ale słabo generalizuje

6/7

Ta praca jest wspólna z @ChuxuanHu, @maxYuxuanZhu, @aokellermann, Calebem Biddulphem, @PunWai i @jasoncbenn

7/7

2,62K

Najlepsze

Ranking

Ulubione