トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

強化学習により、LLMはプログラミング/数学の競争で人間を打ち負かすことができ、最近の進歩を推進しています(OpenAIのoシリーズ、AnthropicのClaude 4)

RL は、事前学習と同じように広範な一般化を可能にするのでしょうか?現在の技術では違います

🧵 1月7日

🔗ここにリンクし、以下のスレッド:

紙:

中程度:

サブスタック:

2/7

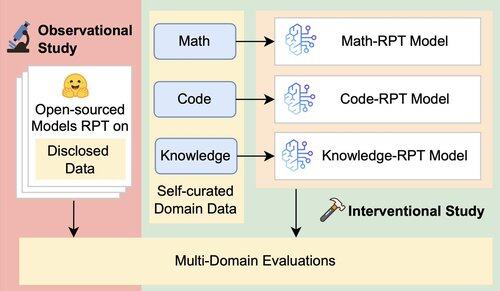

LLMの既存の評価は、混合ドメインデータでトレーニングされ、トレーニングドメインと密接に連携したベンチマークで評価された強化ポストトレーニング(RPT)モデルを使用して、主にドメイン内のパフォーマンスを評価します。これらのセットアップは、RPTの一般化能力の真の範囲を曖昧にする交絡因子を導入します

3/7

数学、コード、知識集約型の推論にわたる16のベンチマークを使用して、RPTのクロスドメイン一般化を分離してテストする統一評価フレームワークを導入します。このフレームワーク内で、基本モデルとRPT戦略のさまざまな組み合わせを評価します

4/7

📌 主な調査結果:

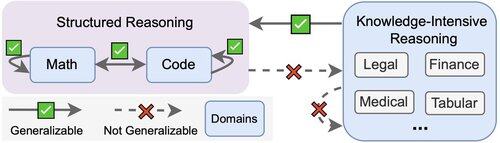

1️⃣ RPTのゲインはほとんどドメイン内です

2️⃣ 数学とコードは互いにうまく一般化されます

3️⃣ 構造化されたスキルは、構造化されていない知識集約型のタスクには移行されません

5/7

持ち帰りは?RPTは強力ですが、狭いです

トレーニングされた場所ではパフォーマンスが向上しますが、一般化は不十分です

6/7

この作品は、@ChuxuanHu、@maxYuxuanZhu、@aokellermann、Caleb Biddulph、@PunWai、および@jasoncbennとの共同です

7/7

2.61K

トップ

ランキング

お気に入り