Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Học tăng cường cho phép các LLM đánh bại con người trong các cuộc thi lập trình/toán học và đã thúc đẩy những tiến bộ gần đây (o-series của OpenAI, Claude 4 của Anthropic)

Liệu RL có cho phép tổng quát rộng rãi theo cách mà việc huấn luyện trước làm không? Không với các kỹ thuật hiện tại

🧵 1/7

🔗Liên kết ở đây và chủ đề bên dưới:

Giấy:

Medium:

Substack:

2/7

Đánh giá hiện tại cho các LLM chủ yếu đánh giá hiệu suất trong miền, sử dụng các mô hình huấn luyện sau tăng cường (RPT) được đào tạo trên dữ liệu miền hỗn hợp và được đánh giá trên các tiêu chuẩn gần gũi với các miền đào tạo của chúng. Những thiết lập này giới thiệu các yếu tố gây nhầm lẫn làm mờ đi mức độ thực sự của khả năng tổng quát của RPT

3/7

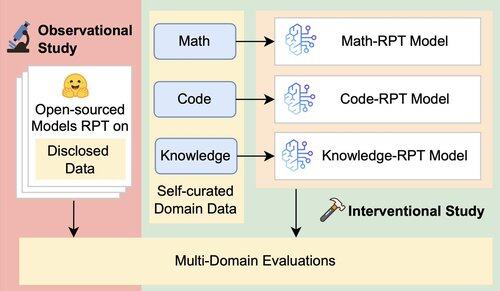

Chúng tôi giới thiệu một khung đánh giá thống nhất mà tách biệt và kiểm tra khả năng tổng quát giữa các miền của RPT bằng cách sử dụng 16 tiêu chuẩn trong các lĩnh vực toán học, mã lập trình và lý luận dựa trên kiến thức. Trong khung này, chúng tôi đánh giá các kết hợp khác nhau của các mô hình cơ sở và các chiến lược RPT

4/7

📌 Những phát hiện chính của chúng tôi:

1️⃣ Lợi nhuận RPT chủ yếu là trong tên miền

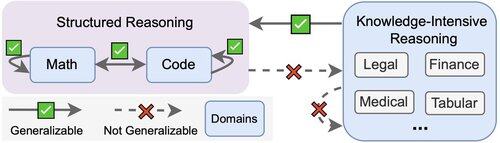

2️⃣ Toán học và mã khái quát tốt với nhau

3️⃣ Các kỹ năng có cấu trúc không chuyển sang các nhiệm vụ phi cấu trúc, chuyên sâu về kiến thức

5/7

Điều rút ra? RPT mạnh mẽ nhưng hẹp

Nó cải thiện hiệu suất nơi nó được đào tạo, nhưng tổng quát kém

6/7

Công việc này là sự hợp tác với @ChuxuanHu, @maxYuxuanZhu, @aokellermann, Caleb Biddulph, @PunWai, và @jasoncbenn

7/7

2,63K

Hàng đầu

Thứ hạng

Yêu thích