Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

L'apprentissage par renforcement permet aux LLM de battre les humains lors de compétitions de programmation/mathématiques et a conduit à des avancées récentes (la série o d'OpenAI, Claude 4 d'Anthropic)

L'apprentissage par renforcement permettra-t-il une généralisation large de la même manière que le pré-entraînement ? Pas avec les techniques actuelles

🧵 1/7

🔗Liens ici et fil ci-dessous :

Document :

Medium :

Substack :

2/7

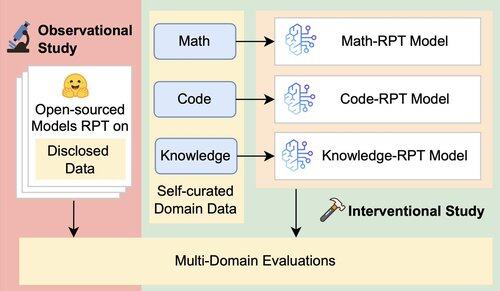

L'évaluation existante des LLMs évalue principalement la performance en domaine, en utilisant des modèles de renforcement post-formation (RPT) entraînés sur des données de domaines mixtes et évalués sur des benchmarks étroitement alignés avec leurs domaines d'entraînement. Ces configurations introduisent des facteurs de confusion qui obscurcissent l'étendue réelle de la capacité de généralisation de RPT.

3/7

Nous introduisons un cadre d'évaluation unifié qui isole et teste la généralisation inter-domaines de RPT en utilisant 16 benchmarks dans les domaines des mathématiques, du code et du raisonnement intensif en connaissances. Dans ce cadre, nous évaluons diverses combinaisons de modèles de base et de stratégies RPT

4/7

📌 Nos principales constatations :

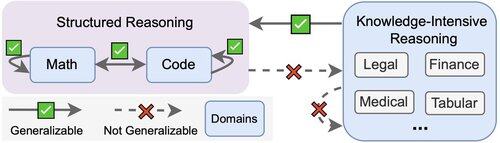

1️⃣ Les gains RPT sont principalement dans le domaine

2️⃣ Les mathématiques et le code se généralisent bien l’un à l’autre

3️⃣ Les compétences structurées ne se transfèrent pas à des tâches non structurées et à forte intensité de connaissances

5/7

La conclusion ? RPT est puissant mais limité

Il améliore les performances là où il est entraîné, mais se généralise mal

6/7

Ce travail est réalisé en collaboration avec @ChuxuanHu, @maxYuxuanZhu, @aokellermann, Caleb Biddulph, @PunWai, et @jasoncbenn

7/7

2,62K

Meilleurs

Classement

Favoris