Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Обучение с подкреплением позволяет LLM обыгрывать людей на конкурсах по программированию/математике и стало движущей силой недавних достижений (o-серия от OpenAI, Claude 4 от Anthropic)

Сможет ли RL обеспечить широкую обобщаемость так же, как это делает предварительное обучение? Нет, с текущими методами

🧵 1/7

🔗Ссылки здесь и ветка ниже:

Документ:

Medium:

Substack:

2/7

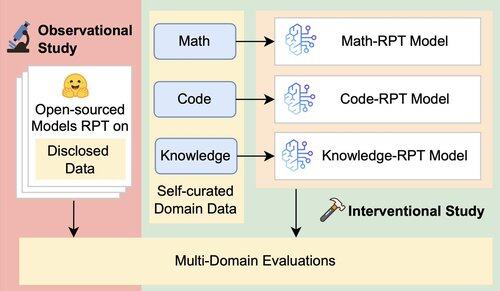

Существующая оценка LLM в основном оценивает производительность в своей области, используя модели пост-тренировки с подкреплением (RPT), обученные на данных смешанных доменов и оцененные по стандартам, тесно связанным с их областями обучения. Эти настройки вводят сбивающие факторы, которые затушевывают истинную степень способности обобщения RPT

3/7

Мы представляем унифицированную оценочную структуру, которая изолирует и тестирует кросс-доменную обобщаемость RPT, используя 16 эталонов в области математики, кода и знания, требующего интенсивного мышления. В рамках этой структуры мы оцениваем различные комбинации базовых моделей и стратегий RPT

4/7

📌 Наши основные выводы:

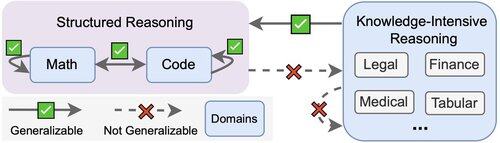

1️⃣ Прирост RPT в основном происходит внутри домена

2️⃣ Математика и код хорошо обобщаются друг для друга

3️⃣ Структурированные навыки не переносятся на неструктурированные, наукоемкие задачи

5/7

Вывод? RPT мощный, но узкий

Он улучшает производительность в тех областях, где его обучали, но плохо обобщает

6/7

Эта работа выполнена совместно с @ChuxuanHu, @maxYuxuanZhu, @aokellermann, Caleb Biddulph, @PunWai и @jasoncbenn

7/7

2,63K

Топ

Рейтинг

Избранное