Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

El aprendizaje por refuerzo permite a los LLM vencer a los humanos en las competiciones de programación/matemáticas y ha impulsado avances recientes (serie o de OpenAI, Claude 4 de Anthropic)

¿Permitirá RL una generalización amplia de la misma manera que lo hace el preentrenamiento? No con las técnicas actuales

🧵 1/7

🔗Enlaces aquí y hilo a continuación:

Papel:

Medio:

Subpila:

2/7

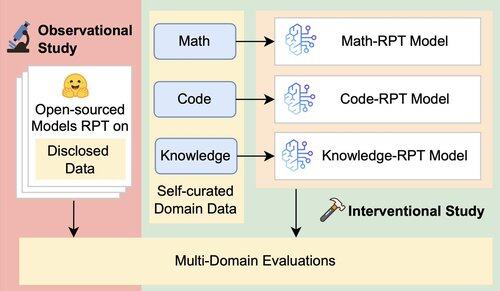

La evaluación existente para los LLM evalúa principalmente el rendimiento en el dominio, utilizando modelos de refuerzo posterior al entrenamiento (RPT) entrenados con datos de dominio mixto y evaluados en puntos de referencia estrechamente alineados con sus dominios de entrenamiento. Estas configuraciones introducen factores de confusión que oscurecen el verdadero alcance de la capacidad de generalización de RPT

3/7

Presentamos un marco de evaluación unificado que aísla y prueba la generalización entre dominios de RPT utilizando 16 puntos de referencia en matemáticas, código y razonamiento intensivo en conocimiento. Dentro de este marco, evaluamos varias combinaciones de modelos base y estrategias RPT

4/7

📌 Nuestros hallazgos clave:

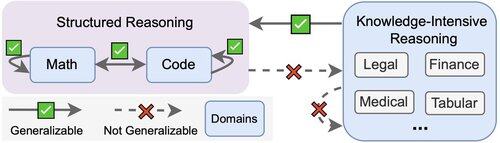

1️⃣ Las ganancias de RPT son principalmente en el dominio

2️⃣ Las matemáticas y el código se generalizan bien entre sí

3️⃣ Las habilidades estructuradas no se transfieren a tareas no estructuradas e intensivas en conocimiento

5/7

¿La conclusión? RPT es potente pero limitado

Mejora el rendimiento donde se entrena, pero generaliza mal

6/7

Este trabajo es conjunto con @ChuxuanHu, @maxYuxuanZhu, @aokellermann, Caleb Biddulph, @PunWai y @jasoncbenn

7/7

2.61K

Populares

Ranking

Favoritas