Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Verstärkendes Lernen ermöglicht es LLMs, Menschen in Programmier-/Mathematikwettbewerben zu schlagen und hat kürzliche Fortschritte vorangetrieben (OpenAIs o-Serie, Anthropics Claude 4)

Wird RL eine breite Generalisierung auf die gleiche Weise ermöglichen wie das Pretraining? Nicht mit den aktuellen Techniken

🧵 1/7

🔗Links hier und Thread unten:

Papier:

Medium:

Substack:

2/7

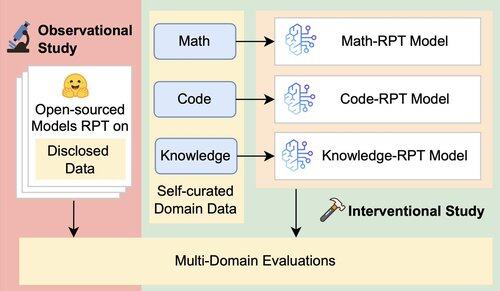

Die bestehende Bewertung von LLMs bewertet hauptsächlich die Leistung im eigenen Bereich, indem sie Reinforcement Post-Training (RPT) Modelle verwendet, die auf gemischten Daten trainiert und an Benchmarks evaluiert werden, die eng mit ihren Trainingsbereichen verbunden sind. Diese Setups führen zu verwirrenden Faktoren, die das wahre Ausmaß der Generalisierungsfähigkeit von RPT verschleiern.

3/7

Wir stellen ein einheitliches Bewertungsrahmenwerk vor, das die bereichsübergreifende Generalisierung von RPT isoliert und mit 16 Benchmarks aus Mathematik, Programmierung und wissensintensivem Denken testet. Innerhalb dieses Rahmens bewerten wir verschiedene Kombinationen von Basis-Modellen und RPT-Strategien

4/7

📌 Unsere wichtigsten Erkenntnisse:

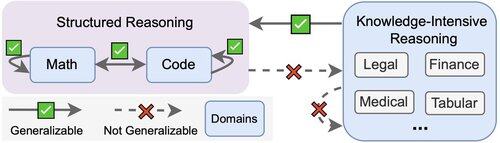

1️⃣ RPT-Gewinne liegen hauptsächlich im Bereich

2️⃣ Mathematik & Code lassen sich gut aufeinander verallgemeinern

3️⃣ Strukturierte Fähigkeiten lassen sich nicht auf unstrukturierte, wissensintensive Aufgaben übertragen

5/7

Die Quintessenz? RPT ist leistungsstark, aber eng gefasst

Es verbessert die Leistung, wo es trainiert wurde, generalisiert jedoch schlecht

6/7

Diese Arbeit ist gemeinsam mit @ChuxuanHu, @maxYuxuanZhu, @aokellermann, Caleb Biddulph, @PunWai und @jasoncbenn

7/7

2,62K

Top

Ranking

Favoriten