Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Forsterkende læring gjør det mulig for LLM-er å slå mennesker på programmerings-/matematikkkonkurranser og har drevet nylige fremskritt (OpenAIs o-serie, Anthropics Claude 4)

Vil RL muliggjøre bred generalisering på samme måte som pretraining gjør? Ikke med dagens teknikker

🧵 1/7

🔗Lenker her og tråd nedenfor:

Papir:

Middels:

Substack:

2/7

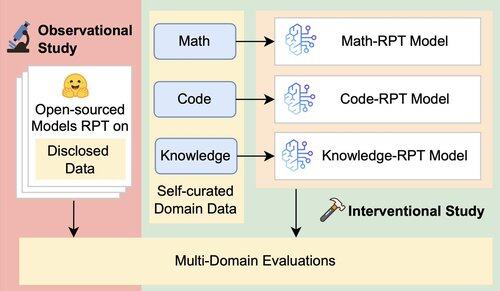

Eksisterende evaluering for LLM-er vurderer først og fremst ytelsen i domenet, ved å bruke forsterkningsmodeller etter trening (RPT) trent på data fra blandede domener og evaluert på benchmarks som er nært knyttet til deres treningsdomener. Disse oppsettene introduserer forvirrende faktorer som tilslører det sanne omfanget av RPTs generaliseringsevne

3/7

Vi introduserer et enhetlig evalueringsrammeverk som isolerer og tester RPTs generalisering på tvers av domener ved hjelp av 16 benchmarks på tvers av matematikk, kode og kunnskapsintensiv resonnement. Innenfor dette rammeverket evaluerer vi ulike kombinasjoner av basismodeller og RPT-strategier

4/7

📌 Våre viktigste funn:

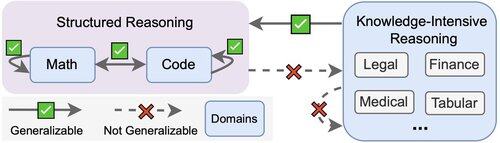

1️⃣ RPT-gevinster er for det meste innenfor domenet

2️⃣ Matematikk og kode generaliserer godt til hverandre

3️⃣ Strukturerte ferdigheter overføres ikke til ustrukturerte, kunnskapsintensive oppgaver

5/7

Takeaway? RPT er kraftig, men smal

Det forbedrer ytelsen der det er trent, men generaliserer dårlig

6/7

Dette arbeidet er felles med @ChuxuanHu, @maxYuxuanZhu, @aokellermann, Caleb Biddulph, @PunWai og @jasoncbenn

7/7

2,57K

Topp

Rangering

Favoritter