熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

強化學習使 LLM 能夠在程式設計/數學競賽中擊敗人類,並推動了最近的進步(OpenAI 的 o 系列、Anthropic 的 Claude 4)

RL 會像預訓練一樣實現廣泛的泛化嗎?不是用當前的技術

🧵 1/7

🔗 此處連結和下面的線程:

紙:

中等:

子堆疊:

2/7

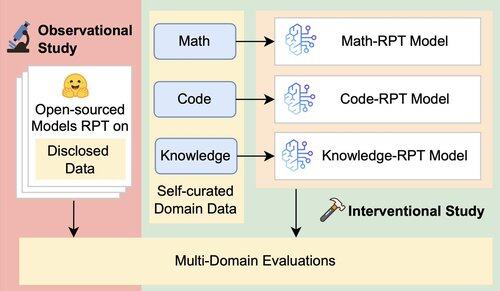

現有的 LLM 評估主要評估域內性能,使用在混合域數據上訓練的強化訓練后 (RPT) 模型,並根據與其訓練域密切相關的基準進行評估。這些設置引入了混雜因素,這些因素掩蓋了 RPT 泛化能力的真實範圍

3/7

我們引入了一個統一的評估框架,該框架使用數學、代碼和知識密集型推理的 16 個基準來隔離和測試 RPT 的跨域泛化。在這個框架內,我們評估了基礎模型和 RPT 策略的各種組合

4/7

📌 我們的主要發現:

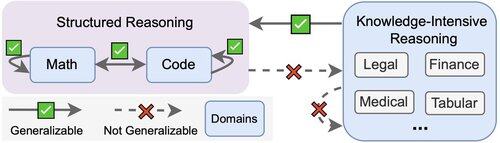

1️⃣ RPT 收益大多在域內

2️⃣ 數學和代碼相互推廣得很好

3️⃣ 結構化技能不會轉移到非結構化的知識密集型任務中

5/7

收穫?RPT 功能強大但範圍狹窄

它在經過訓練的地方提高了性能,但泛化性很差

6/7

這項工作是與 @ChuxuanHu、@maxYuxuanZhu、@aokellermann、Caleb Biddulph、@PunWai 和 @jasoncbenn 聯合完成的

7/7

2.6K

熱門

排行

收藏