热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

强化学习使得大型语言模型在编程/数学竞赛中超越人类,并推动了最近的进展(OpenAI 的 o 系列,Anthropic 的 Claude 4)

强化学习能否像预训练那样实现广泛的泛化?目前的技术无法做到

🧵 1/7

🔗链接在这里,下面是线程:

论文:

Medium:

Substack:

2/7

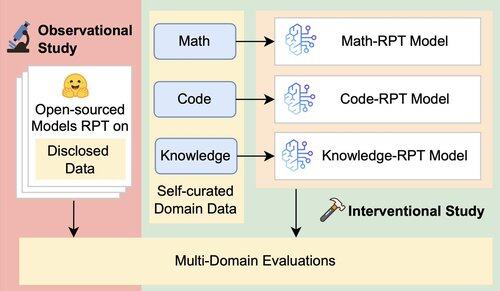

现有的对大型语言模型(LLMs)的评估主要评估其领域内的表现,使用在混合领域数据上训练的强化后训练(RPT)模型,并在与其训练领域密切相关的基准上进行评估。这些设置引入了混淆因素,掩盖了RPT真正的泛化能力的程度

3/7

我们引入了一个统一的评估框架,该框架通过16个基准测试在数学、代码和知识密集型推理中隔离并测试RPT的跨领域泛化。在这个框架内,我们评估了基础模型和RPT策略的各种组合。

4/7

📌 我们的主要发现:

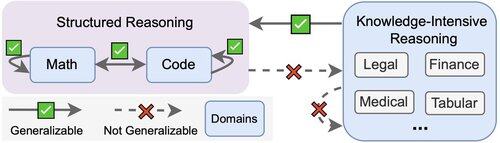

1️⃣ RPT 收益大多在域内

2️⃣ 数学和代码相互推广得很好

3️⃣ 结构化技能不会转移到非结构化的知识密集型任务中

5/7

结论?RPT 功能强大但范围狭窄

它在训练的地方提高了性能,但泛化能力差

6/7

这项工作是与 @ChuxuanHu, @maxYuxuanZhu, @aokellermann, Caleb Biddulph, @PunWai 和 @jasoncbenn 共同完成的

7/7

2.6K

热门

排行

收藏