Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

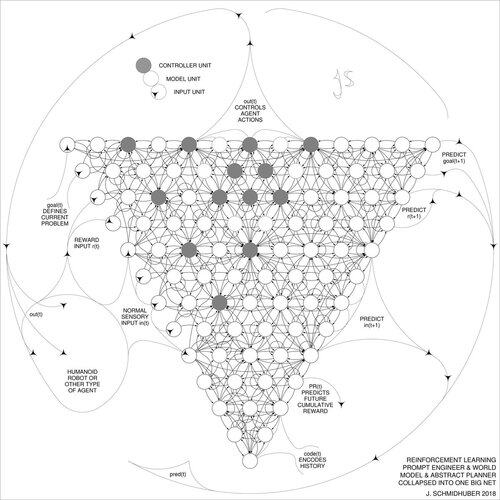

DeepSeek [1] verwendet Elemente des 2015 entwickelten Prompt-Engineers für verstärkendes Lernen [2] und dessen Verfeinerung von 2018 [3], die das RL-Maschinen- und Weltmodell von [2] in ein einzelnes Netz durch das Verfahren der neuronalen Netz-Destillation von 1991 [4] zusammenführt: ein destilliertes Denk-Kettensystem.

REFERENZEN (einfach im Internet zu finden):

[1] #DeepSeekR1 (2025): Anreizsetzung für die Denkfähigkeit in LLMs durch verstärkendes Lernen. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). Über das Lernen zu denken: Algorithmische Informationstheorie für neuartige Kombinationen von verstärkenden Lerncontrollern und rekurrenten neuronalen Weltmodellen. arXiv 1210.0118. Abschnitt 5.3 beschreibt den Prompt-Engineer für verstärkendes Lernen (RL), der lernt, aktiv und iterativ sein Modell für abstraktes Denken sowie Planung und Entscheidungsfindung abzufragen.

[3] JS (2018). Ein großes Netz für alles. arXiv 1802.08864. Siehe auch US11853886B2. Dieses Papier führt den Verstärkungslerner und das Weltmodell von [2] (z. B. ein Fundamentmodell) in ein einzelnes Netzwerk zusammen, wobei das Verfahren der neuronalen Netz-Destillation von 1991 [4] verwendet wird. Im Wesentlichen handelt es sich um ein RL "Denk-Ketten"-System, bei dem nachfolgende Verbesserungen kontinuierlich in ein einzelnes Netz destilliert werden. Siehe auch [5].

[4] JS (1991). Lernen komplexer, erweiterter Sequenzen unter Verwendung des Prinzips der Geschichtskompression. Neural Computation, 4(2):234-242, 1992. Basierend auf TR FKI-148-91, TUM, 1991. Der erste funktionierende Deep Learner basierend auf einer tiefen rekurrenten neuronalen Netz-Hierarchie (mit unterschiedlichen selbstorganisierenden Zeitmaßstäben), der das Problem des verschwindenden Gradienten durch unüberwachtes Pre-Training (das P in CHatGPT) und prädiktive Kodierung überwindet. Auch: Komprimierung oder Destillation eines Lehrer-Netzes (der Chunker) in ein Schüler-Netz (der Automatizer), das seine alten Fähigkeiten nicht vergisst - solche Ansätze sind mittlerweile weit verbreitet. Siehe auch [6].

[5] JS (AI Blog, 2020). 30-jähriges Jubiläum der Planung & des verstärkenden Lernens mit rekurrenten Weltmodellen und künstlicher Neugier (1990, Einführung hochdimensionaler Belohnungssignale und des GAN-Prinzips). Enthält Zusammenfassungen von [2][3] oben.

[6] JS (AI Blog, 2021). 30-jähriges Jubiläum: Erstes sehr tiefes Lernen mit unüberwachtem Pre-Training (1991) [4]. Unüberwachtes hierarchisches prädiktives Kodieren findet kompakte interne Darstellungen sequentieller Daten, um das nachgelagerte Lernen zu erleichtern. Die Hierarchie kann [4] in ein einzelnes tiefes neuronales Netzwerk destilliert werden. 1993: Lösung von Problemen der Tiefe >1000.

786,99K

Top

Ranking

Favoriten