Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

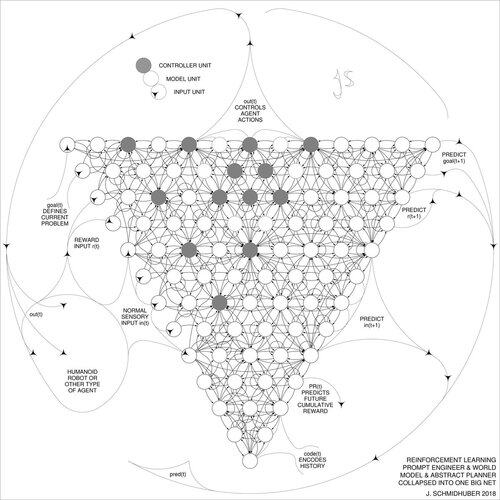

O DeepSeek [1] usa elementos do engenheiro de prompt de aprendizado por reforço de 2015 [2] e seu refinamento de 2018 [3] que colapsa a máquina RL e o modelo de mundo de [2] em uma única rede por meio do procedimento de destilação de rede neural de 1991 [4]: uma cadeia destilada de sistema de pensamento.

REFERÊNCIAS (fáceis de encontrar na web):

[1] #DeepSeekR1 (2025): Incentivando a capacidade de raciocínio em LLMs por meio de aprendizado por reforço. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). Sobre Aprender a Pensar: Teoria da Informação Algorítmica para Novas Combinações de Controladores de Aprendizado por Reforço e Modelos de Mundo Neural Recorrente. arXiv 1210.0118. A Seção 5.3 descreve o engenheiro de prompt de aprendizado por reforço (RL) que aprende a consultar ativa e iterativamente seu modelo para raciocínio abstrato, planejamento e tomada de decisão.

[3] JS (2018). Uma grande rede para tudo. arXiv 1802.08864. Veja também US11853886B2. Este artigo colapsa o aprendiz de reforço e o modelo de mundo de [2] (por exemplo, um modelo de fundação) em uma única rede, usando o procedimento de destilação de rede neural de 1991 [4]. Essencialmente, o que agora é chamado de sistema RL "Chain of Thought", onde as melhorias subsequentes são continuamente destiladas em uma única rede. Veja também [5].

[4] JS (1991). Aprendendo sequências complexas e estendidas usando o princípio da compressão da história. Computação Neural, 4(2):234-242, 1992. Baseado em TR FKI-148-91, TUM, 1991. Primeiro trabalhando com base em uma hierarquia de rede neural recorrente profunda (com diferentes escalas de tempo auto-organizadas), superando o problema do gradiente de fuga por meio de pré-treinamento não supervisionado (o P em CHatGPT) e codificação preditiva. Além disso: comprimir ou destilar uma rede de professores (o chunker) em uma rede de alunos (o automatizador) que não esquece suas antigas habilidades - essas abordagens agora são amplamente utilizadas. Veja também [6].

[5] JS (AI Blog, 2020). Aniversário de 30 anos de planejamento e aprendizado por reforço com modelos de mundo recorrentes e curiosidade artificial (1990, introduzindo sinais de recompensa de alta dimensão e o princípio GAN). Contém resumos de [2][3] acima.

[6] JS (AI Blog, 2021). Aniversário de 30 anos: Primeiro aprendizado muito profundo com pré-treinamento não supervisionado (1991) [4]. A codificação preditiva hierárquica não supervisionada encontra representações internas compactas de dados sequenciais para facilitar o aprendizado downstream. A hierarquia pode ser destilada [4] em uma única rede neural profunda. 1993: resolução de problemas de profundidade >1000.

787,04K

Melhores

Classificação

Favoritos