Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

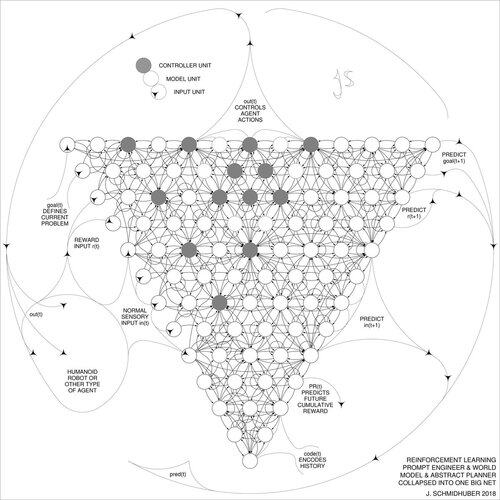

DeepSeek [1] gebruikt elementen van de 2015 versterkende leerprompt engineer [2] en zijn verfijning uit 2018 [3], die het RL-machine- en wereldmodel van [2] samenvoegt tot een enkel netwerk via de neurale netdistillatieprocedure van 1991 [4]: een gedistilleerd denkproces.

REFERENTIES (gemakkelijk te vinden op het web):

[1] #DeepSeekR1 (2025): Het stimuleren van redeneercapaciteit in LLM's via versterkend leren. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). Over leren denken: Algoritmische informatietheorie voor nieuwe combinaties van versterkende leercontrollers en terugkerende neurale wereldmodellen. arXiv 1210.0118. Sectie 5.3 beschrijft de versterkende leer (RL) prompt engineer die leert om actief en iteratief zijn model te ondervragen voor abstract redeneren en planning en besluitvorming.

[3] JS (2018). Eén groot netwerk voor alles. arXiv 1802.08864. Zie ook US11853886B2. Dit artikel voegt de versterkende leerling en het wereldmodel van [2] (bijv. een fundamentmodel) samen tot een enkel netwerk, met gebruik van de neurale netwerkdistillatieprocedure van 1991 [4]. In wezen wat nu een RL "Chain of Thought" systeem wordt genoemd, waar daaropvolgende verbeteringen voortdurend worden gedistilleerd in een enkel netwerk. Zie ook [5].

[4] JS (1991). Leren van complexe, uitgebreide sequenties met behulp van het principe van geschiedeniscompressie. Neural Computation, 4(2):234-242, 1992. Gebaseerd op TR FKI-148-91, TUM, 1991. Eerste werkende diepe leerling gebaseerd op een diepe terugkerende neurale net hiërarchie (met verschillende zelforganiserende tijdschalen), die het verdwijnende gradientprobleem overwint door ongecontroleerde voortraining (de P in CHatGPT) en voorspellende codering. Ook: het comprimeren of distilleren van een lerarenet (de chunker) in een studentennet (de automatizer) dat zijn oude vaardigheden niet vergeet - dergelijke benaderingen worden nu veel gebruikt. Zie ook [6].

[5] JS (AI Blog, 2020). 30-jarig jubileum van planning & versterkend leren met terugkerende wereldmodellen en kunstmatige nieuwsgierigheid (1990, introductie van hoogdimensionale beloningssignalen en het GAN-principe). Bevat samenvattingen van [2][3] hierboven.

[6] JS (AI Blog, 2021). 30-jarig jubileum: Eerste zeer diepe leren met ongecontroleerde voortraining (1991) [4]. Ongecontroleerde hiërarchische voorspellende codering vindt compacte interne representaties van sequentiële gegevens om downstream leren te vergemakkelijken. De hiërarchie kan [4] worden gedistilleerd tot een enkel diep neuraal netwerk. 1993: problemen oplossen van diepte >1000.

787,02K

Boven

Positie

Favorieten