Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

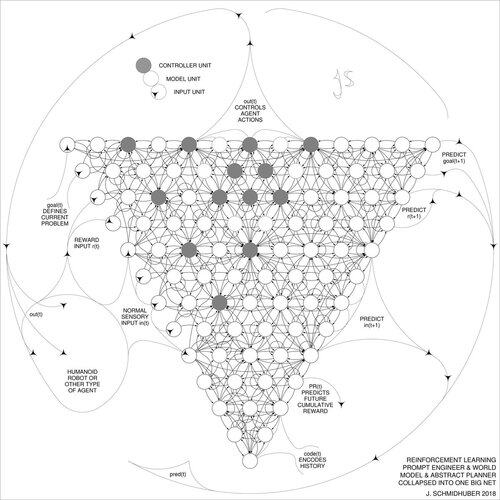

DeepSeek [1] utiliza elementos del ingeniero de prompts de aprendizaje por refuerzo de 2015 [2] y su refinamiento de 2018 [3], que colapsa el modelo de máquina de RL y el modelo del mundo de [2] en una sola red a través del procedimiento de destilación de redes neuronales de 1991 [4]: un sistema de cadena de pensamiento destilado.

REFERENCIAS (fácil de encontrar en la web):

[1] #DeepSeekR1 (2025): Incentivando la capacidad de razonamiento en LLMs a través del aprendizaje por refuerzo. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). Sobre aprender a pensar: Teoría de la información algorítmica para combinaciones novedosas de controladores de aprendizaje por refuerzo y modelos de mundo neuronales recurrentes. arXiv 1210.0118. La Sección 5.3 describe el ingeniero de prompts de aprendizaje por refuerzo (RL) que aprende a consultar activamente e iterativamente su modelo para el razonamiento abstracto, la planificación y la toma de decisiones.

[3] JS (2018). Una gran red para todo. arXiv 1802.08864. Véase también US11853886B2. Este artículo colapsa el aprendiz por refuerzo y el modelo del mundo de [2] (por ejemplo, un modelo base) en una sola red, utilizando el procedimiento de destilación de redes neuronales de 1991 [4]. Esencialmente lo que ahora se llama un sistema de "Cadena de Pensamiento" de RL, donde las mejoras posteriores se destilan continuamente en una sola red. Véase también [5].

[4] JS (1991). Aprendiendo secuencias complejas y extendidas utilizando el principio de compresión de la historia. Neural Computation, 4(2):234-242, 1992. Basado en TR FKI-148-91, TUM, 1991. Primer aprendiz profundo funcional basado en una jerarquía de red neuronal recurrente profunda (con diferentes escalas de tiempo autoorganizadas), superando el problema del gradiente que desaparece a través del preentrenamiento no supervisado (la P en CHatGPT) y la codificación predictiva. También: comprimiendo o destilando una red docente (el fragmentador) en una red estudiante (el automatizador) que no olvida sus habilidades antiguas - tales enfoques son ahora ampliamente utilizados. Véase también [6].

[5] JS (AI Blog, 2020). 30 aniversario de la planificación y el aprendizaje por refuerzo con modelos de mundo recurrentes y curiosidad artificial (1990, introduciendo señales de recompensa de alta dimensión y el principio GAN). Contiene resúmenes de [2][3] arriba.

[6] JS (AI Blog, 2021). 30 aniversario: Primer aprendizaje muy profundo con preentrenamiento no supervisado (1991) [4]. La codificación predictiva jerárquica no supervisada encuentra representaciones internas compactas de datos secuenciales para facilitar el aprendizaje posterior. La jerarquía puede ser destilada [4] en una sola red neuronal profunda. 1993: resolviendo problemas de profundidad >1000.

787,02K

Parte superior

Clasificación

Favoritos