Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

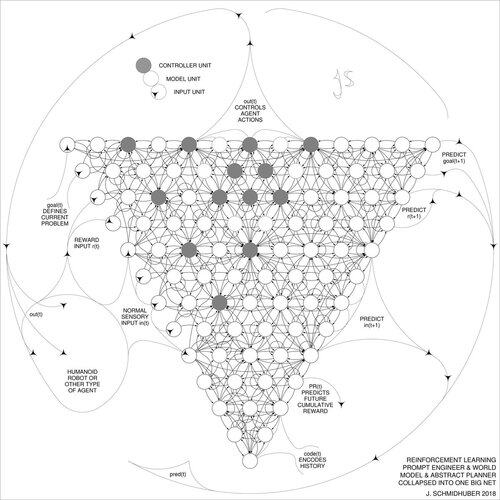

DeepSeek [1] bruker elementer fra 2015 reinforcement learning prompt engineer [2] og dens 2018-foredling [3] som kollapser RL-maskinen og verdensmodellen av [2] til et enkelt nett gjennom nevrale nettdestillasjonsprosedyren fra 1991 [4]: en destillert kjede av tankesystem.

REFERANSER (lett å finne på nettet):

[1] #DeepSeekR1 (2025): Insentiver til resonneringsevne i LLM-er via forsterkende læring. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). Om å lære å tenke: Algoritmisk informasjonsteori for nye kombinasjoner av forsterkende læringskontrollere og tilbakevendende nevrale verdensmodeller. arXiv 1210.0118. Seksjon 5.3 beskriver forsterkningslæringsingeniøren (RL) som lærer å aktivt og iterativt spørre modellen for abstrakt resonnement og planlegging og beslutningstaking.

[3] JS (2018). Ett stort nett for alt. arXiv 1802.08864. Se også US11853886B2. Denne artikkelen kollapser forsterkningseleven og verdensmodellen til [2] (f.eks. en grunnmodell) til ett enkelt nettverk, ved å bruke nevrale nettverksdestillasjonsprosedyren fra 1991 [4]. I hovedsak det som nå kalles et RL "Chain of Thought"-system, der påfølgende forbedringer kontinuerlig destilleres til ett enkelt nett. Se også [5].

[4] JS (1991). Lære komplekse, utvidede sekvenser ved hjelp av prinsippet om historiekomprimering. Nevral beregning, 4(2):234-242, 1992. Basert på TR FKI-148-91, TUM, 1991. Først å jobbe dypt lærende basert på et dypt tilbakevendende nevralt netthierarki (med forskjellige selvorganiserende tidsskalaer), overvinne problemet med forsvinnende gradient gjennom uovervåket forhåndstrening (P i CHatGPT) og prediktiv koding. Også: komprimere eller destillere et lærernett (chunkeren) til et elevnett (automatisatoren) som ikke glemmer sine gamle ferdigheter - slike tilnærminger er nå mye brukt. Se også [6].

[5] JS (AI-blogg, 2020). 30-årsjubileum for planlegging og forsterkende læring med tilbakevendende verdensmodeller og kunstig nysgjerrighet (1990, introduserer høydimensjonale belønningssignaler og GAN-prinsippet). Inneholder sammendrag av [2][3] ovenfor.

[6] JS (AI-blogg, 2021). 30-årsjubileum: Første veldig dype læring med uveiledet fortrening (1991) [4]. Uovervåket hierarkisk prediktiv koding finner kompakte interne representasjoner av sekvensielle data for å lette nedstrøms læring. Hierarkiet kan destilleres [4] til et enkelt dypt nevralt nettverk. 1993: Løsning av dybdeproblemer >1000.

786,98K

Topp

Rangering

Favoritter