Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

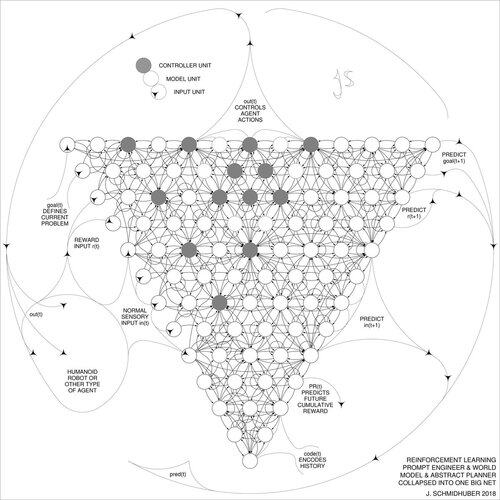

DeepSeek [1] використовує елементи інженера підказки навчання з підкріпленням 2015 року [2] та його доопрацювання 2018 року [3], яке згортає машину RL та модель світу [2] в єдину мережу за допомогою процедури дистиляції нейронної мережі 1991 року [4]: дистильований ланцюг системи мислення.

СПИСОК ЛІТЕРАТУРИ (легко знайти в Інтернеті):

[1] #DeepSeekR1 (2025): Стимулювання здатності міркувати в LLM за допомогою навчання з підкріпленням. arXiv 2501.12948

[2] Й. Шмідгубер (JS, 2015). Про навчання мислити: алгоритмічна теорія інформації для нових комбінацій контролерів навчання з підкріпленням і рекурентних моделей нейронних світів. arXiv 1210.0118. У розділі 5.3 описується інженер з підкріпленням (RL), який вчиться активно та ітеративно запитувати свою модель для абстрактного міркування та планування та прийняття рішень.

[3] JS (2018). Одна велика сітка для всього. arXiv 1802.08864. Дивіться також US11853886B2. У цій роботі об'єднано учня з підкріпленням і модель світу [2] (наприклад, базову модель) в єдину мережу, використовуючи процедуру дистиляції нейронних мереж 1991 року [4]. По суті, це те, що зараз називається системою RL «Ланцюг думок», де подальші вдосконалення постійно переганяються в єдину мережу. Див також [5].

[4] JS (1991). Розучування складних, розширених послідовностей з використанням принципу стиснення історії. Нейронні обчислення, 4(2):234-242, 1992. На основі ТР ФКІ-148-91, ТУМ, 1991. Перший працюючий глибоке навчання на основі глибокої рекурентної ієрархії нейронних мереж (з різними часовими шкалами, що самоорганізуються), подолання проблеми зникаючого градієнта за допомогою попереднього навчання без нагляду (P у CHatGPT) та прогнозного кодування. Також: стиснення або перегонка вчительської сітки (чанкера) в учнівську сітку (автоматизатор), яка не забуває свої старі навички - такі підходи зараз широко використовуються. Див також [6].

[5] JS (AI Blog, 2020). 30-річчя планування та навчання з підкріпленням з використанням повторюваних моделей світу та штучної цікавості (1990 р., впровадження високорозмірних сигналів винагороди та принципу GAN). Містить резюме [2][3] вище.

[6] JS (AI Blog, 2021). 30-річний ювілей: перше дуже глибоке навчання з попереднім навчанням без нагляду (1991) [4]. Неконтрольоване ієрархічне прогнозне кодування знаходить компактні внутрішні представлення послідовних даних для полегшення подальшого навчання. Ієрархія може бути дистильована [4] в єдину глибоку нейронну мережу. 1993: розв'язування задач глибини >1000.

786,99K

Найкращі

Рейтинг

Вибране