Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

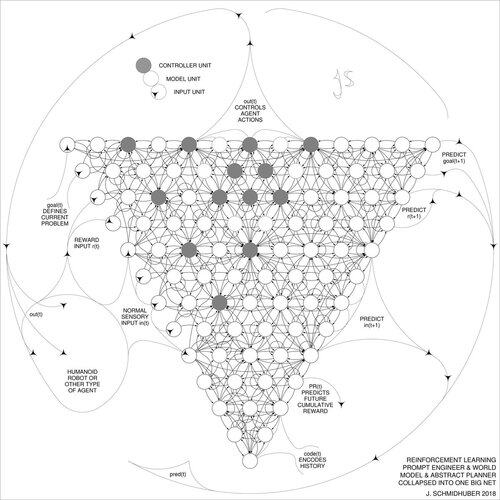

DeepSeek [1] wykorzystuje elementy inżynierii podpowiedzi wzmocnienia z 2015 roku [2] oraz jej udoskonalenie z 2018 roku [3], które łączy model RL i model świata z [2] w jedną sieć poprzez procedurę destylacji sieci neuronowej z 1991 roku [4]: destylowany system łańcucha myślenia.

REFERENCJE (łatwe do znalezienia w sieci):

[1] #DeepSeekR1 (2025): Zachęcanie do zdolności rozumowania w LLM za pomocą uczenia przez wzmocnienie. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). O uczeniu się myśleć: Algorytmiczna teoria informacji dla nowych kombinacji kontrolerów uczenia przez wzmocnienie i rekurencyjnych modeli świata neuronowego. arXiv 1210.0118. Sekcja 5.3 opisuje inżynierię podpowiedzi RL, która uczy się aktywnie i iteracyjnie pytać swój model o abstrakcyjne rozumowanie oraz planowanie i podejmowanie decyzji.

[3] JS (2018). Jedna wielka sieć dla wszystkiego. arXiv 1802.08864. Zobacz także US11853886B2. Ten artykuł łączy ucznia wzmocnienia i model świata z [2] (np. model podstawowy) w jedną sieć, wykorzystując procedurę destylacji sieci neuronowej z 1991 roku [4]. W zasadzie to, co teraz nazywa się systemem RL "Łańcucha Myślenia", w którym kolejne ulepszenia są nieustannie destylowane w jedną sieć. Zobacz także [5].

[4] JS (1991). Uczenie się złożonych, rozszerzonych sekwencji przy użyciu zasady kompresji historii. Neural Computation, 4(2):234-242, 1992. Na podstawie TR FKI-148-91, TUM, 1991. Pierwszy działający głęboki uczący się oparty na hierarchii głębokiej sieci neuronowej (z różnymi samorganizującymi się skalami czasowymi), pokonujący problem znikającego gradientu poprzez niesuperwizyjne wstępne uczenie (P w CHatGPT) i kodowanie predykcyjne. Również: kompresowanie lub destylowanie sieci nauczyciela (chunker) w sieć ucznia (automatizer), która nie zapomina swoich starych umiejętności - takie podejścia są obecnie szeroko stosowane. Zobacz także [6].

[5] JS (Blog AI, 2020). 30-lecie planowania i uczenia przez wzmocnienie z rekurencyjnymi modelami świata i sztuczną ciekawością (1990, wprowadzając sygnały nagrody o wysokiej wymiarowości i zasadę GAN). Zawiera podsumowania [2][3] powyżej.

[6] JS (Blog AI, 2021). 30-lecie: Pierwsze bardzo głębokie uczenie się z niesuperwizyjnym wstępnym uczeniem (1991) [4]. Niesuperwizyjne hierarchiczne kodowanie predykcyjne znajduje kompaktowe wewnętrzne reprezentacje danych sekwencyjnych, aby ułatwić uczenie się w dół. Hierarchię można destylować [4] w jedną głęboką sieć neuronową. 1993: rozwiązywanie problemów głębokości >1000.

787K

Najlepsze

Ranking

Ulubione