Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

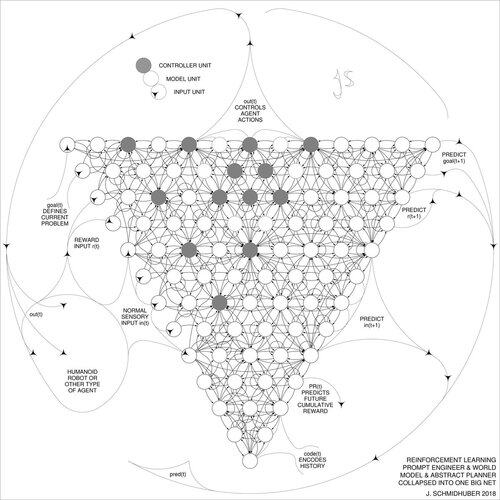

DeepSeek [1] utilise des éléments de l'ingénierie de prompt d'apprentissage par renforcement de 2015 [2] et son perfectionnement de 2018 [3] qui fusionne le modèle de machine RL et le modèle du monde de [2] en un seul réseau grâce à la procédure de distillation de réseau neuronal de 1991 [4] : un système de chaîne de pensée distillée.

RÉFÉRENCES (faciles à trouver sur le web) :

[1] #DeepSeekR1 (2025) : Incitation à la capacité de raisonnement dans les LLM via l'apprentissage par renforcement. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). Sur l'apprentissage à penser : Théorie de l'information algorithmique pour des combinaisons nouvelles de contrôleurs d'apprentissage par renforcement et de modèles de monde neuronaux récurrents. arXiv 1210.0118. La section 5.3 décrit l'ingénierie de prompt d'apprentissage par renforcement (RL) qui apprend à interroger activement et itérativement son modèle pour le raisonnement abstrait, la planification et la prise de décision.

[3] JS (2018). Un grand réseau pour tout. arXiv 1802.08864. Voir aussi US11853886B2. Cet article fusionne l'apprenant par renforcement et le modèle du monde de [2] (par exemple, un modèle de base) en un seul réseau, en utilisant la procédure de distillation de réseau neuronal de 1991 [4]. Essentiellement ce qu'on appelle maintenant un système "Chaîne de Pensée" RL, où les améliorations successives sont continuellement distillées en un seul réseau. Voir aussi [5].

[4] JS (1991). Apprendre des séquences complexes et étendues en utilisant le principe de compression de l'histoire. Neural Computation, 4(2) :234-242, 1992. Basé sur TR FKI-148-91, TUM, 1991. Premier apprenant profond fonctionnel basé sur une hiérarchie de réseaux neuronaux récurrents profonds (avec différentes échelles de temps auto-organisées), surmontant le problème du gradient qui disparaît grâce à un pré-entraînement non supervisé (le P dans CHatGPT) et au codage prédictif. Aussi : compresser ou distiller un réseau enseignant (le chunker) en un réseau étudiant (l'automatisateur) qui n'oublie pas ses anciennes compétences - de telles approches sont maintenant largement utilisées. Voir aussi [6].

[5] JS (AI Blog, 2020). 30e anniversaire de la planification et de l'apprentissage par renforcement avec des modèles de monde récurrents et de la curiosité artificielle (1990, introduction de signaux de récompense de haute dimension et du principe GAN). Contient des résumés de [2][3] ci-dessus.

[6] JS (AI Blog, 2021). 30e anniversaire : Premier apprentissage très profond avec pré-entraînement non supervisé (1991) [4]. Le codage prédictif hiérarchique non supervisé trouve des représentations internes compactes de données séquentielles pour faciliter l'apprentissage en aval. La hiérarchie peut être distillée [4] en un seul réseau neuronal profond. 1993 : résoudre des problèmes de profondeur >1000.

787K

Meilleurs

Classement

Favoris