トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

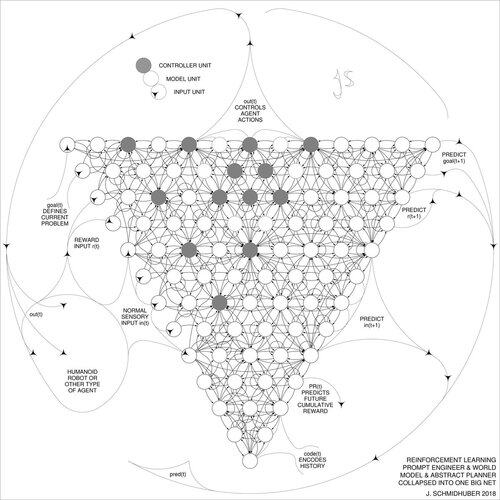

DeepSeek [1] は、2015 の強化学習プロンプト エンジニア [2] とその 2018 年の改良 [3] の要素を使用しており、1991 年のニューラル ネット蒸留手順[4] を通じて [2] を 1 つのネットに折りたたむことができます。

参考文献(ウェブ上で簡単に見つけることができます):

[1] #DeepSeekR1 (2025): [強化学習によるLLMの推論能力のインセンティブ化]arXiv 2501.12948

[2] J.シュミットフーバー(JS、2015年)。考えるための学習について:強化学習コントローラーと再帰型ニューラルワールドモデルの新しい組み合わせのためのアルゴリズム情報理論。arXiv 1210.0118。セクション5.3では、抽象的な推論、計画、および意思決定のためにモデルを積極的かつ反復的にクエリすることを学習する強化学習(RL)プロンプトエンジニアについて説明します。

[3] JS (2018年).1つの大きなネットですべてに。arXiv 1802.08864。US11853886B2も参照してください。この論文では、1991年のニューラルネットワーク蒸留手順を使用して、強化学習器と[2]の世界モデル(基礎モデルなど)を1つのネットワークに折りたたむ[4]。基本的には、現在RLの「Chain of Thought」システムと呼ばれているもので、その後の改善が継続的に1つのネットに抽出されます。[5]も参照してください。

[ 4 ] JS ( 1991 ) 。履歴圧縮の原理を使用して、複雑で拡張されたシーケンスを学習します。ニューラルコンピュテーション, 4(2):234-242, 1992.TR FKI-148-91、TUM、1991年に基づいています。まず、深いリカレントニューラルネット階層(異なる自己組織化時間スケール)に基づいて深層学習を行い、教師なしの事前学習(CHatGPTのP)と予測コーディングを通じて勾配消失問題を克服します。また、教師用ネット(チャンカー)を圧縮または蒸留して、古いスキルを忘れない学生用ネット(オートマタイザー)にすることも、現在では広く利用されています。[6] も参照してください。

[5] JS (AIブログ、2020年)。再帰型世界モデルと人工的好奇心による計画と強化学習の30周年(1990年、高次元報酬信号とGAN原理を導入)。上記の [2][3] の要約が含まれています。

[6] JS (AIブログ、2021年)。30周年記念:教師なし事前学習による初の超深層学習(1991年)[4]。教師なし階層予測コーディングは、シーケンシャルデータのコンパクトな内部表現を見つけて、ダウンストリーム学習を容易にします。階層は [4] 、1 つのディープ ニューラル ネットワークに抽出できます。1993年:深さ>1000の問題を解決する。

787K

トップ

ランキング

お気に入り