Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

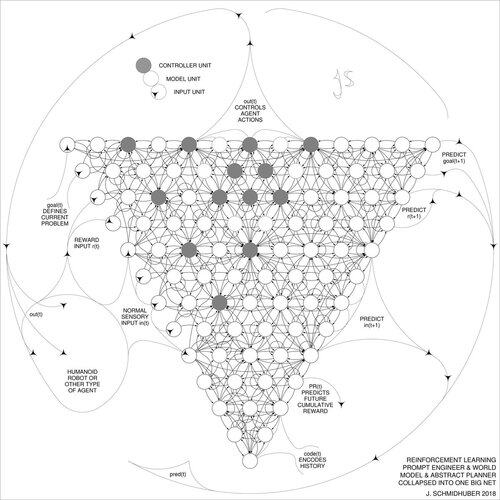

DeepSeek [1] использует элементы инженера по обучению с подкреплением 2015 года [2] и его усовершенствование 2018 года [3], которое объединяет RL-машину и мировую модель из [2] в единую сеть через процедуру дистилляции нейронной сети 1991 года [4]: дистиллированная система цепочки размышлений.

СПИСОК ЛИТЕРАТУРЫ (легко найти в интернете):

[1] #DeepSeekR1 (2025): Стимулирование способности к рассуждению в LLM через обучение с подкреплением. arXiv 2501.12948

[2] J. Шмидхубер (JS, 2015). О том, как научиться мыслить: Алгоритмическая теория информации для новых комбинаций контроллеров обучения с подкреплением и рекуррентных нейронных мировых моделей. arXiv 1210.0118. Раздел 5.3 описывает инженера по обучению с подкреплением (RL), который учится активно и итеративно запрашивать свою модель для абстрактного рассуждения, планирования и принятия решений.

[3] JS (2018). Одна большая сеть для всего. arXiv 1802.08864. См. также US11853886B2. Эта работа объединяет обучающего с подкреплением и мировую модель из [2] (например, базовую модель) в единую сеть, используя процедуру дистилляции нейронной сети 1991 года [4]. По сути, это то, что сейчас называется системой "Цепочка размышлений" RL, где последующие улучшения постоянно дистиллируются в единую сеть. См. также [5].

[4] JS (1991). Обучение сложным, расширенным последовательностям с использованием принципа сжатия истории. Нейронные вычисления, 4(2):234-242, 1992. Основано на TR FKI-148-91, TUM, 1991. Первый работающий глубокий обучающий алгоритм на основе иерархии глубоких рекуррентных нейронных сетей (с различными самоорганизующимися временными шкалами), преодолевающий проблему исчезающего градиента через несупервизируемое предварительное обучение (P в CHatGPT) и предсказательное кодирование. Также: сжатие или дистилляция сети учителя (разделитель) в сеть ученика (автоматизатор), которая не забывает свои старые навыки - такие подходы сейчас широко используются. См. также [6].

[5] JS (AI Blog, 2020). 30-летие планирования и обучения с подкреплением с рекуррентными мировыми моделями и искусственным любопытством (1990, введение высокоразмерных сигналов вознаграждения и принципа GAN). Содержит резюме [2][3] выше.

[6] JS (AI Blog, 2021). 30-летие: Первое очень глубокое обучение с несупервизируемым предварительным обучением (1991) [4]. Несупервизируемое иерархическое предсказательное кодирование находит компактные внутренние представления последовательных данных для облегчения последующего обучения. Иерархию можно дистиллировать [4] в единую глубокую нейронную сеть. 1993: решение проблем глубины >1000.

787,02K

Топ

Рейтинг

Избранное