Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

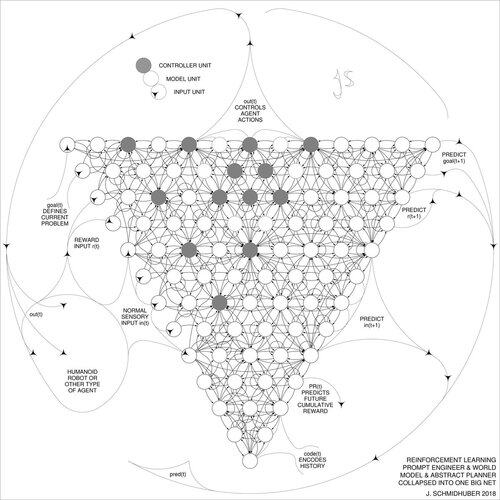

DeepSeek [1] utilizza elementi dell'ingegneria dei prompt di apprendimento per rinforzo del 2015 [2] e il suo affinamento del 2018 [3], che collassa il modello di apprendimento per rinforzo e il modello del mondo di [2] in una rete unica attraverso la procedura di distillazione della rete neurale del 1991 [4]: un sistema di catena di pensiero distillato.

RIFERIMENTI (facili da trovare sul web):

[1] #DeepSeekR1 (2025): Incentivare la capacità di ragionamento nei LLM tramite l'apprendimento per rinforzo. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). Sull'apprendimento a pensare: Teoria dell'informazione algoritmica per nuove combinazioni di controllori di apprendimento per rinforzo e modelli di mondo neurali ricorrenti. arXiv 1210.0118. La Sez. 5.3 descrive l'ingegneria dei prompt di apprendimento per rinforzo (RL) che impara a interrogare attivamente e iterativamente il suo modello per il ragionamento astratto, la pianificazione e la presa di decisioni.

[3] JS (2018). Una grande rete per tutto. arXiv 1802.08864. Vedi anche US11853886B2. Questo documento collassa l'apprenditore per rinforzo e il modello del mondo di [2] (ad es., un modello di base) in un'unica rete, utilizzando la procedura di distillazione della rete neurale del 1991 [4]. Essenzialmente quello che ora è chiamato un sistema di "Catena di Pensiero" RL, dove i miglioramenti successivi vengono continuamente distillati in una rete unica. Vedi anche [5].

[4] JS (1991). Apprendere sequenze complesse e prolungate utilizzando il principio della compressione della storia. Neural Computation, 4(2):234-242, 1992. Basato su TR FKI-148-91, TUM, 1991. Primo apprenditore profondo funzionante basato su una gerarchia di reti neurali ricorrenti profonde (con diverse scale temporali auto-organizzanti), superando il problema del gradiente che svanisce attraverso il pre-addestramento non supervisionato (il P in CHatGPT) e il coding predittivo. Inoltre: comprimere o distillare una rete insegnante (il chunker) in una rete studente (l'automatizer) che non dimentica le sue vecchie abilità - tali approcci sono ora ampiamente utilizzati. Vedi anche [6].

[5] JS (AI Blog, 2020). 30° anniversario della pianificazione e dell'apprendimento per rinforzo con modelli di mondo ricorrenti e curiosità artificiale (1990, introduzione di segnali di ricompensa ad alta dimensione e principio GAN). Contiene riassunti di [2][3] sopra.

[6] JS (AI Blog, 2021). 30° anniversario: Primo apprendimento molto profondo con pre-addestramento non supervisionato (1991) [4]. Il coding predittivo gerarchico non supervisionato trova rappresentazioni interne compatte di dati sequenziali per facilitare l'apprendimento a valle. La gerarchia può essere distillata [4] in una singola rete neurale profonda. 1993: risolvere problemi di profondità >1000.

786,99K

Principali

Ranking

Preferiti