热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

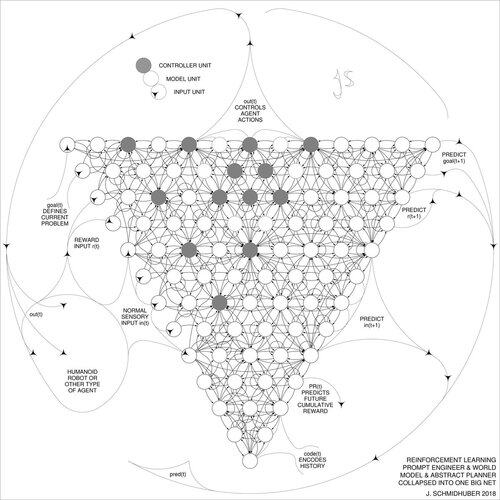

DeepSeek [1] 使用2015年强化学习提示工程师 [2] 的元素及其2018年的改进 [3],将 [2] 的强化学习机器和世界模型合并为一个单一的网络,通过1991年的神经网络蒸馏程序 [4]:一个蒸馏的思维链系统。

参考文献(在网上容易找到):

[1] #DeepSeekR1 (2025):通过强化学习激励LLMs的推理能力。arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015)。关于学习思考:算法信息理论用于强化学习控制器和递归神经世界模型的新组合。arXiv 1210.0118。第5.3节描述了强化学习(RL)提示工程师,该工程师学习主动和迭代地查询其模型以进行抽象推理、规划和决策。

[3] JS (2018)。一个为所有事物而设的大网络。arXiv 1802.08864。另见US11853886B2。本文将 [2] 的强化学习者和世界模型(例如,基础模型)合并为一个单一网络,使用1991年的神经网络蒸馏程序 [4]。本质上,现在称为RL的“思维链”系统,其中后续改进不断蒸馏到一个单一网络中。另见 [5]。

[4] JS (1991)。使用历史压缩原理学习复杂的扩展序列。神经计算,4(2):234-242,1992。基于TR FKI-148-91,TUM,1991。第一个基于深度递归神经网络层次的工作深度学习者(具有不同的自组织时间尺度),通过无监督预训练(CHatGPT中的P)和预测编码克服消失梯度问题。此外:将教师网络(分块器)压缩或蒸馏到学生网络(自动化器)中,该网络不会忘记其旧技能——这种方法现在被广泛使用。另见 [6]。

[5] JS (AI博客,2020)。规划与强化学习及递归世界模型和人工好奇心的30周年(1990年,引入高维奖励信号和GAN原理)。包含上述 [2][3] 的摘要。

[6] JS (AI博客,2021)。30周年:第一次非常深度学习与无监督预训练(1991) [4]。无监督的层次预测编码找到序列数据的紧凑内部表示,以促进下游学习。该层次可以蒸馏 [4] 为一个单一的深度神经网络。1993年:解决深度 >1000 的问题。

786.99K

热门

排行

收藏