Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

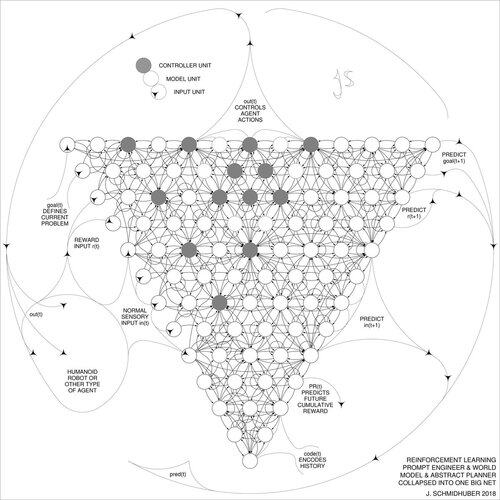

DeepSeek [1] folosește elemente ale inginerului prompt de învățare prin întărire din 2015 [2] și rafinamentul său din 2018 [3] care prăbușește mașina RL și modelul mondial al [2] într-o singură rețea prin procedura de distilare a rețelei neuronale din 1991 [4]: un sistem de gândire distilat.

REFERINȚE (ușor de găsit pe web):

[1] #DeepSeekR1 (2025): Stimularea capacității de raționament în LLM-uri prin învățare prin întărire. arXiv 2501.12948

[2] J. Schmidhuber (JS, 2015). Despre învățarea gândirii: teoria informației algoritmice pentru noi combinații de controlori de învățare prin întărire și modele recurente ale lumii neuronale. arXiv 1210.0118. Sec. 5.3 descrie inginerul prompt de învățare prin întărire (RL) care învață să-și interogheze în mod activ și iterativ modelul pentru raționament, planificare abstractă și luare a deciziilor.

[3] JS (2018). O plasă mare pentru orice. arXiv 1802.08864. Vezi și US11853886B2. Această lucrare colapsează cursantul de întărire și modelul mondial al [2] (de exemplu, un model de bază) într-o singură rețea, folosind procedura de distilare a rețelei neuronale din 1991 [4]. În esență, ceea ce se numește acum un sistem RL "Chain of Thought", în care îmbunătățirile ulterioare sunt distilate continuu într-o singură rețea. Vezi și [5].

[4] JS (1991). Învățarea secvențelor complexe și extinse folosind principiul compresiei istoriei. Calcul neuronal, 4(2):234-242, 1992. Bazat pe TR FKI-148-91, TUM, 1991. Primul învățător profund care lucrează pe baza unei ierarhii profunde recurente a rețelei neuronale (cu diferite scări de timp auto-organizate), depășirea problemei gradientului de dispariție prin pre-antrenament nesupravegheat (P în CHatGPT) și codificare predictivă. De asemenea: comprimarea sau distilarea unei rețele de profesori (fragmentatorul) într-o rețea de elevi (automatizatorul) care nu uită vechile sale abilități - astfel de abordări sunt acum utilizate pe scară largă. Vezi și [6].

[5] JS (AI Blog, 2020). Aniversarea a 30 de ani de planificare și învățare prin întărire cu modele mondiale recurente și curiozitate artificială (1990, introducând semnale de recompensă de înaltă dimensiune și principiul GAN). Conține rezumate ale [2][3] de mai sus.

[6] JS (AI Blog, 2021). Aniversarea a 30 de ani: Prima învățare foarte profundă cu pre-instruire nesupravegheată (1991) [4]. Codificarea predictivă ierarhică nesupravegheată găsește reprezentări interne compacte ale datelor secvențiale pentru a facilita învățarea în aval. Ierarhia poate fi distilată [4] într-o singură rețea neuronală profundă. 1993: rezolvarea problemelor de adâncime >1000.

787,05K

Limită superioară

Clasament

Favorite