Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

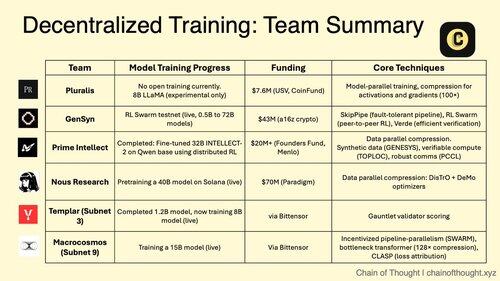

1/ Dezentrale KI-Trainings verschieben sich von unmöglich zu unvermeidlich.

Die Ära der zentralisierten KI-Monopole wird durch bahnbrechende Protokolle herausgefordert, die ein kollaboratives Modelltraining über verteilte Netzwerke ermöglichen.

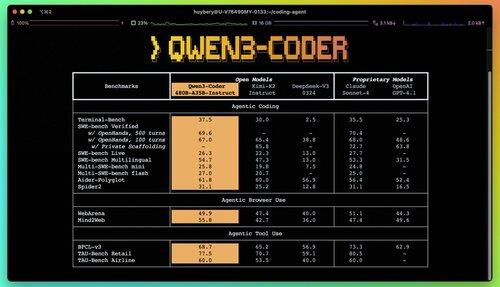

2/ Primer Alert: Qwen 3 Coder wurde gerade veröffentlicht und ist ein Game Changer.

Das neue 480B-Parameter MoE-Modell mit 35B aktiven Parametern erreicht eine Spitzenleistung bei agentischen Codierungsaufgaben und rivalisiert Claude Sonnet 4.

Dieser vollständig Open-Source-Coder unterstützt nativ 256K Kontext und 1M mit Extrapolation.

3/ Pluralis ist Pionier in "Protocol Learning", einem radikalen Ansatz, bei dem Modelle kollaborativ trainiert werden, aber niemals vollständig an einem einzigen Ort materialisiert werden.

Eine Seed-Runde von 7,6 Millionen Dollar von USV und CoinFund unterstützt ihre Vision von wirklich offener KI, bei der Mitwirkende den wirtschaftlichen Nutzen teilen, ohne die Kontrolle über das Modell aufzugeben.

@PluralisHQ 4/ Nous Research hat 50 Millionen Dollar gesammelt, um OpenAI mit gemeinschaftlich verwalteten Modellen herauszufordern.

Ihr bevorstehendes 40B-Parameter-Modell "Consilience" verwendet das Psyche-Framework mit JPEG-inspirierten Kompressionstechniken, um ein effizientes verteiltes Training über heterogene Hardware zu ermöglichen.

5/ Gensyn hat bis heute etwa 51 Millionen US-Dollar gesichert, um den "globalen Machine Learning Cluster" aufzubauen.

Ihr Protokoll verbindet weltweit untergenutzte Rechenleistung, von Rechenzentren bis hin zu Gaming-Laptops, und schafft eine dezentrale Cloud-Alternative, die wirtschaftliche Kennzahlen erreichen könnte, die über denen zentralisierter Anbieter liegen.

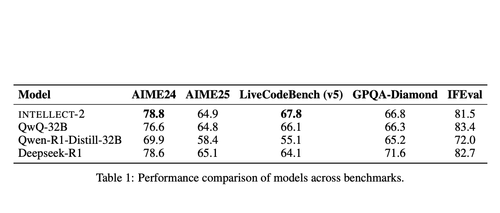

@gensynai 6/ Prime Intellect hat bewiesen, dass dezentrales Training mit INTELLECT-2 funktioniert.

Ihr 32B-Parameter-Modell wurde über global verteiltes RL mit dem PRIME-RL-Framework trainiert, was zeigt, dass Grenzmodelle über Kontinente hinweg aufgebaut werden können, ohne die Leistung zu opfern.

@PrimeIntellect 7/ Bittensor-Subnetze spezialisieren sich auf KI-Workloads:

- Subnetz 3 (Templar) konzentriert sich auf die Validierung des verteilten Trainings.

- Subnetz 9 (Macrocosmos) ermöglicht die kollaborative Modellentwicklung und schafft wirtschaftliche Anreize für die Teilnehmer im neuronalen Netzwerk.

8/ Die dezentrale Trainingsthese: Mehr Rechenleistung aggregieren als jede einzelne Einheit, den Zugang zur KI-Entwicklung demokratisieren und die Konzentration von Macht verhindern.

Da die Kosten für Inferenz bei den Denkmodellen höher sind als beim Training, könnten verteilte Netzwerke zur wesentlichen Infrastruktur in der KI-Wirtschaft werden.

8,13K

Top

Ranking

Favoriten