Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

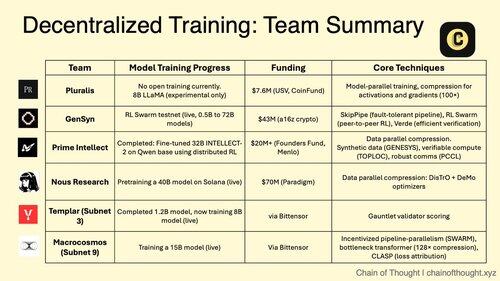

1/ La formation d'IA décentralisée passe de l'impossible à l'inévitable.

L'ère des monopoles d'IA centralisés est remise en question par des protocoles révolutionnaires qui permettent la formation collaborative de modèles à travers des réseaux distribués.

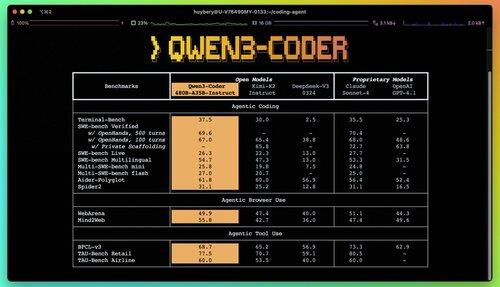

2/ Alerte Primer : Qwen 3 Coder vient de sortir et c'est un véritable changement de jeu.

Le nouveau modèle MoE de 480 milliards de paramètres avec 35 milliards de paramètres actifs atteint des performances de pointe dans les tâches de codage agentique, rivalisant avec Claude Sonnet 4.

Ce codeur entièrement open-source prend en charge 256K de contexte nativement et 1M avec extrapolation.

3/ Pluralis est à l'avant-garde de l'"Apprentissage par Protocole", une approche radicale où les modèles sont formés de manière collaborative mais ne se matérialisent jamais complètement en un seul endroit.

Un tour de financement de 7,6 millions de dollars de USV et CoinFund soutient leur vision d'une IA véritablement ouverte où les contributeurs partagent les bénéfices économiques sans renoncer au contrôle du modèle.

@PluralisHQ 4/ Nous Research raised $50M to challenge OpenAI with community-governed models.

Their upcoming 40B parameter "Consilience" model uses the Psyche framework with JPEG-inspired compression to enable efficient distributed training across heterogeneous hardware.

5/ Gensyn a sécurisé environ 51 millions de dollars à ce jour pour construire le "cluster mondial d'apprentissage automatique."

Leur protocole connecte des ressources de calcul sous-utilisées à travers le monde, des centres de données aux ordinateurs portables de jeu, créant une alternative cloud décentralisée qui pourrait atteindre des économies d'échelle supérieures à celles des fournisseurs centralisés.

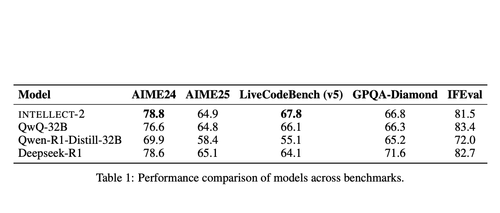

@gensynai 6/ Prime Intellect a prouvé que l'entraînement décentralisé fonctionne avec INTELLECT-2.

Leur modèle de 32 milliards de paramètres a été entraîné via un apprentissage par renforcement distribué à l'échelle mondiale en utilisant le cadre PRIME-RL, démontrant que des modèles de pointe peuvent être construits à travers les continents sans sacrifier la performance.

@PrimeIntellect 7/ Les sous-réseaux Bittensor se spécialisent dans les charges de travail d'IA :

- Le sous-réseau 3 (Templar) se concentre sur la validation de l'entraînement distribué.

- Le sous-réseau 9 (Macrocosmos) permet le développement collaboratif de modèles, créant des incitations économiques pour les participants au réseau neuronal.

8/ La thèse de la formation décentralisée : Agréger plus de puissance de calcul qu'une seule entité, démocratiser l'accès au développement de l'IA et prévenir la concentration du pouvoir.

Alors que les modèles de raisonnement augmentent les coûts d'inférence au-delà de ceux de la formation, les réseaux distribués pourraient devenir une infrastructure essentielle dans l'économie de l'IA.

8,24K

Meilleurs

Classement

Favoris