Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

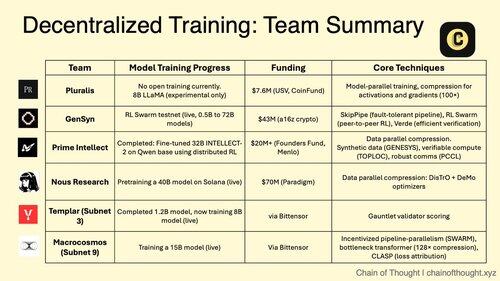

1/ Zdecentralizowane szkolenie AI przechodzi z niemożliwego do nieuniknionego.

Era scentralizowanych monopolii AI jest kwestionowana przez przełomowe protokoły, które umożliwiają współpracujące szkolenie modeli w rozproszonych sieciach.

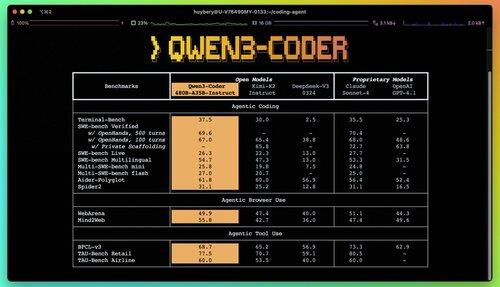

2/ Alert: Qwen 3 Coder właśnie się pojawił i to zmienia zasady gry.

Nowy model MoE z 480 miliardami parametrów i 35 miliardami aktywnych parametrów osiąga najlepsze wyniki w zadaniach kodowania agentowego, rywalizując z Claude Sonnet 4.

Ten w pełni otwarty kod wspiera natywnie 256K kontekstu i 1M z ekstrapolacją.

3/ Pluralis wprowadza "Protocol Learning", radykalne podejście, w którym modele są trenowane wspólnie, ale nigdy nie są w pełni zmaterializowane w żadnej pojedynczej lokalizacji.

$7,6M w rundzie seed od USV i CoinFund wspiera ich wizję prawdziwie otwartej AI, w której uczestnicy dzielą się korzyściami ekonomicznymi, nie rezygnując z kontroli nad modelem.

@PluralisHQ 4/ Nous Research zebrało 50 milionów dolarów, aby stawić czoła OpenAI z modelami zarządzanymi przez społeczność.

Ich nadchodzący model "Consilience" o 40 miliardach parametrów wykorzystuje framework Psyche z kompresją inspirowaną JPEG, aby umożliwić efektywne rozproszone szkolenie na heterogenicznym sprzęcie.

5/ Gensyn zabezpieczył do tej pory około 51 milionów dolarów na budowę "globalnego klastra uczenia maszynowego."

Ich protokół łączy niedostatecznie wykorzystywane zasoby obliczeniowe na całym świecie, od centrów danych po laptopy do gier, tworząc zdecentralizowaną alternatywę chmurową, która może osiągnąć ekonomię jednostkową przewyższającą dostawców centralnych.

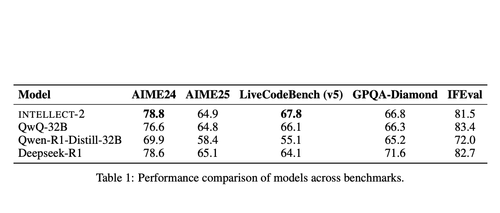

@gensynai 6/ Prime Intellect udowodnił, że zdecentralizowane szkolenie działa z INTELLECT-2.

Ich model o 32 miliardach parametrów został wytrenowany za pomocą globalnie rozproszonego RL przy użyciu frameworka PRIME-RL, co pokazuje, że modele na czołowej linii mogą być budowane na różnych kontynentach bez utraty wydajności.

@PrimeIntellect 7/ Podsieci Bittensor specjalizują się w obciążeniach AI:

- Podsieć 3 (Templar) koncentruje się na walidacji rozproszonego treningu.

- Podsieć 9 (Macrocosmos) umożliwia współpracę w rozwoju modeli, tworząc zachęty ekonomiczne dla uczestników w sieci neuronowej.

8/ Teza dotycząca zdecentralizowanego szkolenia: Zgromadź więcej mocy obliczeniowej niż jakikolwiek pojedynczy podmiot, zdemokratyzuj dostęp do rozwoju AI i zapobiegaj koncentracji władzy.

Ponieważ modele rozumowania podnoszą koszty wnioskowania wyżej niż koszty szkolenia, sieci rozproszone mogą stać się niezbędną infrastrukturą w gospodarce AI.

7,89K

Najlepsze

Ranking

Ulubione