Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

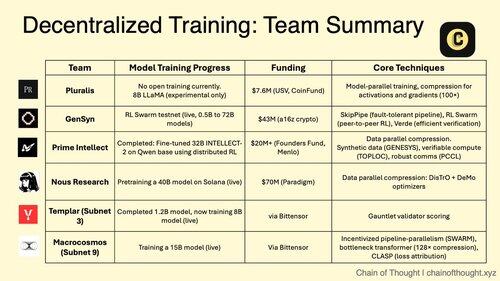

1/ Desentralisert AI-trening skifter fra umulig til uunngåelig.

Epoken med sentraliserte AI-monopoler blir utfordret av banebrytende protokoller som muliggjør opplæring av samarbeidsmodeller på tvers av distribuerte nettverk.

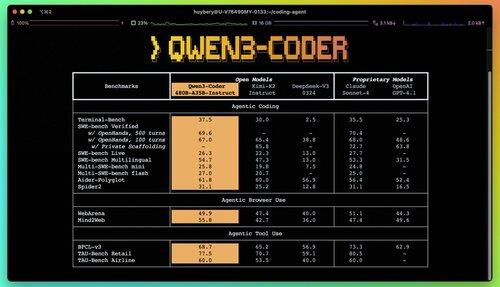

2/ Primer Alert: Qwen 3 Coder har nettopp falt og det er en game changer.

Den nye MoE-modellen med 480B-parameter med 35B aktive parametere oppnår toppmoderne ytelse i agentkodingsoppgaver, og konkurrerer med Claude Sonnet 4.

Denne fullstendig åpen kildekode-koderen støtter 256K-kontekst og 1M med ekstrapolering.

3/ Pluralis er banebrytende "Protocol Learning", en radikal tilnærming der modeller trenes i samarbeid, men aldri materialiseres fullt ut på et enkelt sted.

7,6 millioner dollar fra USV og CoinFund støtter deres visjon om virkelig åpen AI der bidragsytere deler økonomisk oppside uten å gi fra seg modellkontroll.

@PluralisHQ 4/ Nous Research samlet inn 50 millioner dollar for å utfordre OpenAI med fellesskapsstyrte modeller.

Deres kommende 40B-parameter "Consilience"-modell bruker Psyche-rammeverket med JPEG-inspirert komprimering for å muliggjøre effektiv distribuert trening på tvers av heterogen maskinvare.

5/ Gensyn har sikret ~51 millioner dollar til dags dato for å bygge den "globale maskinlæringsklyngen."

Protokollen deres kobler sammen underutnyttet databehandling over hele verden, fra datasentre til bærbare spilldatamaskiner, og skaper et desentralisert skyalternativ som kan oppnå enhetsøkonomi som overgår sentraliserte leverandører.

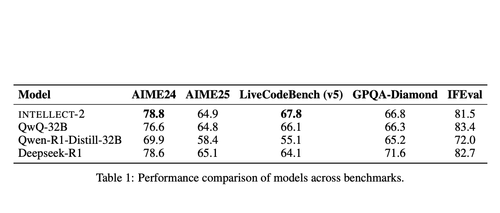

@gensynai 6/ Prime Intellect beviste at desentralisert trening fungerer med INTELLECT-2.

Deres 32B-parametermodell ble trent via globalt distribuert RL ved hjelp av PRIME-RL-rammeverket, og demonstrerte at frontmodeller kan bygges på tvers av kontinenter uten å ofre ytelsen.

@PrimeIntellect 7/ Bittensor-delnett spesialiserer seg på AI-arbeidsbelastninger:

- Subnett 3 (Templar) fokuserer på distribuert opplæringsvalidering.

- Subnett 9 (Macrocosmos) muliggjør utvikling av samarbeidsmodeller, og skaper økonomiske insentiver for deltakere i det nevrale nettverket.

8/ Den desentraliserte treningsoppgaven: Samle mer databehandling enn noen enkelt enhet, demokratisere tilgangen til AI-utvikling og forhindre konsentrasjon av makt.

Ettersom resonneringsmodeller driver slutningskostnadene høyere enn opplæring, kan distribuerte nettverk bli viktig infrastruktur i AI-økonomien.

8,11K

Topp

Rangering

Favoritter