Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

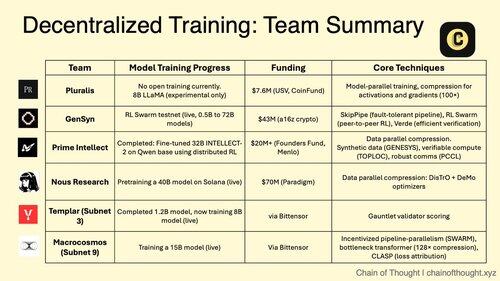

1/ O treinamento descentralizado de IA está mudando de impossível para inevitável.

A era dos monopólios centralizados de IA está sendo desafiada por protocolos inovadores que permitem o treinamento colaborativo de modelos em redes distribuídas.

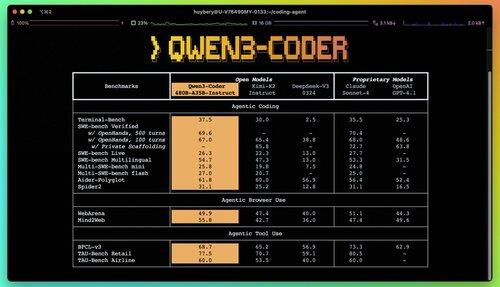

2/ Alerta de Primer: Qwen 3 Coder acabou de cair e é um divisor de águas.

O novo modelo MoE de 480B parâmetros com 35B parâmetros ativos alcança desempenho de última geração em tarefas de codificação agêntica, rivalizando com Claude Sonnet 4.

Este codificador totalmente de código aberto suporta contexto de 256K nativamente e 1M com extrapolação.

3/ A Pluralis é pioneira no "Protocol Learning", uma abordagem radical em que os modelos são treinados de forma colaborativa, mas nunca totalmente materializados em um único local.

A rodada inicial de US$ 7,6 milhões da USV e da CoinFund apóia sua visão de IA verdadeiramente aberta, onde os contribuintes compartilham vantagens econômicas sem abrir mão do controle do modelo.

@PluralisHQ 4/ Nous Research levantou US$ 50 milhões para desafiar a OpenAI com modelos governados pela comunidade.

Seu próximo modelo de "Consiliência" de parâmetro 40B usa a estrutura Psyche com compactação inspirada em JPEG para permitir um treinamento distribuído eficiente em hardware heterogêneo.

5/ A Gensyn garantiu ~ US$ 51 milhões até o momento para construir o "cluster global de aprendizado de máquina".

Seu protocolo conecta computação subutilizada em todo o mundo, de data centers a laptops para jogos, criando uma alternativa de nuvem descentralizada que poderia alcançar a economia unitária superando os provedores centralizados.

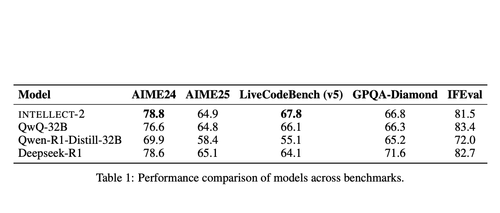

@gensynai 6/ Prime Intellect provou que o treinamento descentralizado funciona com o INTELLECT-2.

Seu modelo de parâmetro 32B foi treinado por meio de RL distribuído globalmente usando a estrutura PRIME-RL, demonstrando que os modelos de fronteira podem ser construídos em todos os continentes sem sacrificar o desempenho.

@PrimeIntellect 7/ sub-redes Bittensor são especializadas para cargas de trabalho de IA:

- A sub-rede 3 (Templário) se concentra na validação de treinamento distribuído.

- A sub-rede 9 (Macrocosmos) permite o desenvolvimento colaborativo de modelos, criando incentivos econômicos para os participantes da rede neural.

8/ A tese do treinamento descentralizado: agregue mais computação do que qualquer entidade única, democratize o acesso ao desenvolvimento de IA e evite a concentração de poder.

Como os modelos de raciocínio aumentam os custos de inferência do que o treinamento, as redes distribuídas podem se tornar uma infraestrutura essencial na economia da IA.

8,25K

Melhores

Classificação

Favoritos