热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

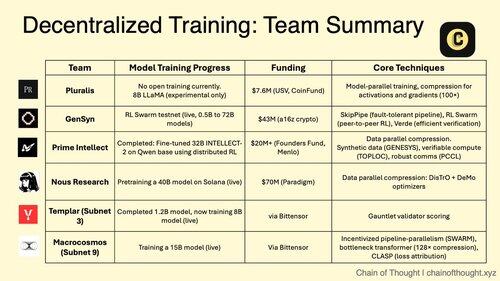

1/ 去中心化的人工智能训练正从不可能转变为不可避免。

集中式人工智能垄断的时代正受到突破性协议的挑战,这些协议使得在分布式网络中进行协作模型训练成为可能。

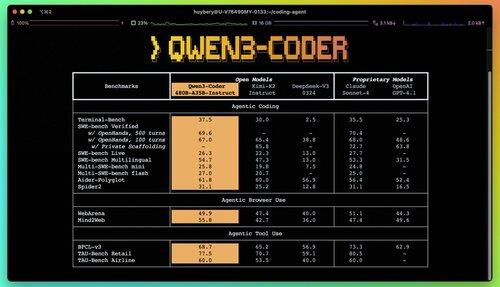

2/ 提醒:Qwen 3 Coder 刚刚发布,这是一个游戏规则改变者。

这个新的 480B 参数 MoE 模型具有 35B 活跃参数,在代理编码任务中达到了最先进的性能,堪比 Claude Sonnet 4。

这个完全开源的编码器原生支持 256K 上下文,经过外推可支持 1M。

3/ Pluralis 正在开创 "协议学习",这是一种激进的方法,模型以协作的方式进行训练,但从未在任何单一地点完全实现。

来自 USV 和 CoinFund 的 760 万美元种子轮融资支持他们对真正开放的 AI 的愿景,在这个愿景中,贡献者分享经济收益而不放弃模型控制权。

@PluralisHQ 4/ Nous Research 筹集了 5000 万美元,以社区治理的模型挑战 OpenAI。

他们即将推出的 400 亿参数的 "Consilience" 模型使用 Psyche 框架,并采用 JPEG 风格的压缩,以实现跨异构硬件的高效分布式训练。

5/ Gensyn 至今已获得约 5100 万美元的资金,以建立 "全球机器学习集群。"

他们的协议连接了全球未充分利用的计算资源,从数据中心到游戏笔记本电脑,创造了一种去中心化的云替代方案,可能实现超越集中式提供商的单位经济。

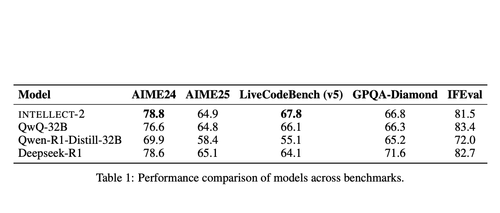

@gensynai 6/ Prime Intellect 证明了去中心化训练通过 INTELLECT-2 的有效性。

他们的 32B 参数模型通过全球分布的 RL 使用 PRIME-RL 框架进行训练,展示了前沿模型可以在不同大陆之间构建,而不牺牲性能。

@PrimeIntellect 7/ Bittensor 子网专注于 AI 工作负载:

- 子网 3 (Templar) 专注于分布式训练验证。

- 子网 9 (Macrocosmos) 促进协作模型开发,为神经网络中的参与者创造经济激励。

8/ 去中心化训练论:聚合比任何单一实体更多的计算能力,民主化AI开发的访问权限,并防止权力集中。

随着推理模型使推理成本高于训练,分布式网络可能成为AI经济中的基础设施。

8.11K

热门

排行

收藏